为本地编码助手配置 Ollama 和 Continue VS Code 扩展

🔗 链接

先决条件

- Ollama已安装在您的系统上。您可以访问Ollama并根据您的系统下载应用程序。

- 我们将在这里使用的 AI 模型是 Codellama。您可以使用您喜欢的模型。Code Llama 是一个用于生成和讨论代码的模型,它基于 Llama 2 构建。Code Llama 支持许多最流行的编程语言,包括 Python、C++、Java、PHP、Typescript (Javascript)、C#、Bash 等。如果尚未安装,您可以使用以下命令安装:

ollama pull codellama

您还可以Starcoder 2 3B通过运行以下命令来安装代码自动完成功能:

ollama pull starcoder2:3b

注意:选择与您的系统兼容的型号至关重要,以确保顺利运行并避免出现任何问题。

安装 Continue 并配置

您可以从VS Code 商店的这里安装 Continue 。

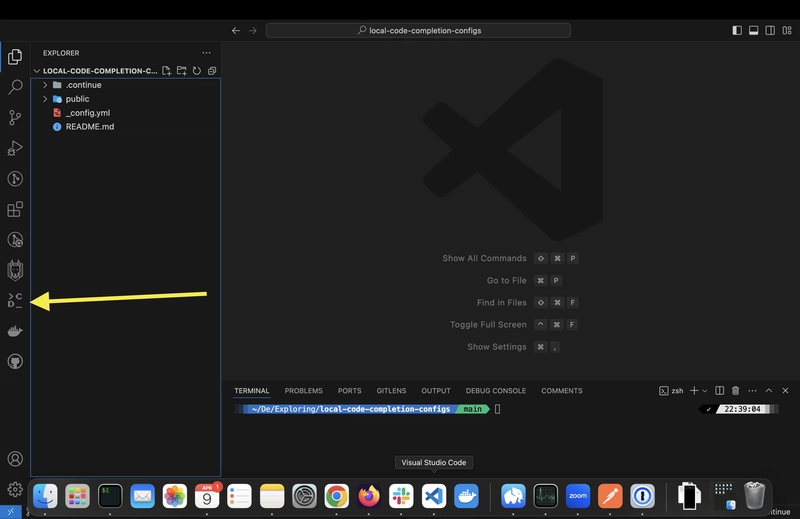

安装后,您应该在侧栏中看到它,如下所示:

配置继续使用本地模型

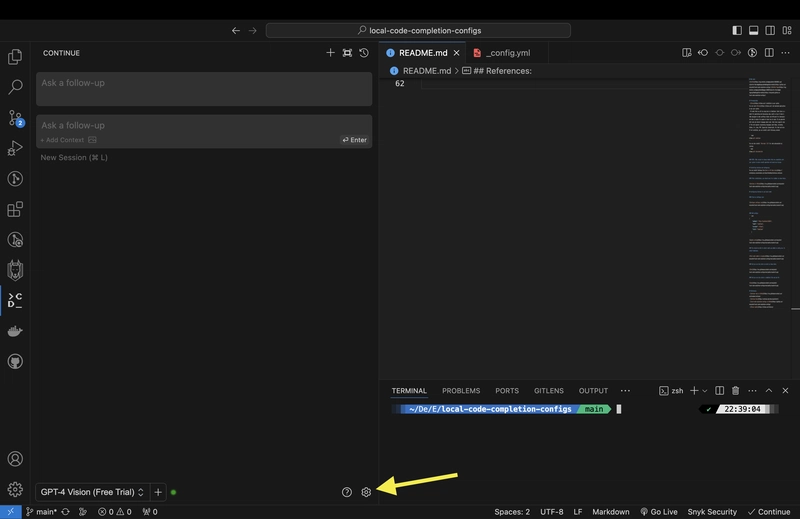

点击设置图标:

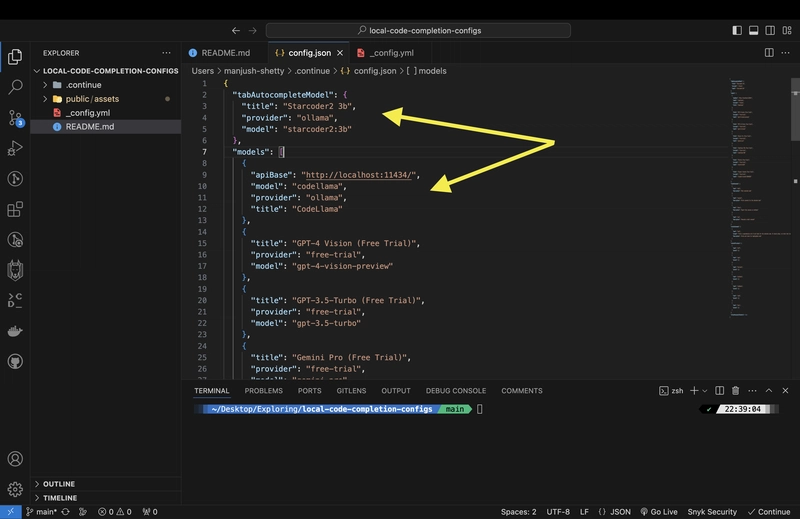

添加配置:

{

"apiBase": "http://localhost:11434/",

"model": "codellama",

"provider": "ollama",

"title": "CodeLlama"

}

并tabAutocompleteModel添加

"tabAutocompleteModel": {

"apiBase": "http://localhost:11434/",

"title": "Starcoder2 3b",

"provider": "ollama",

"model": "starcoder2:3b"

}

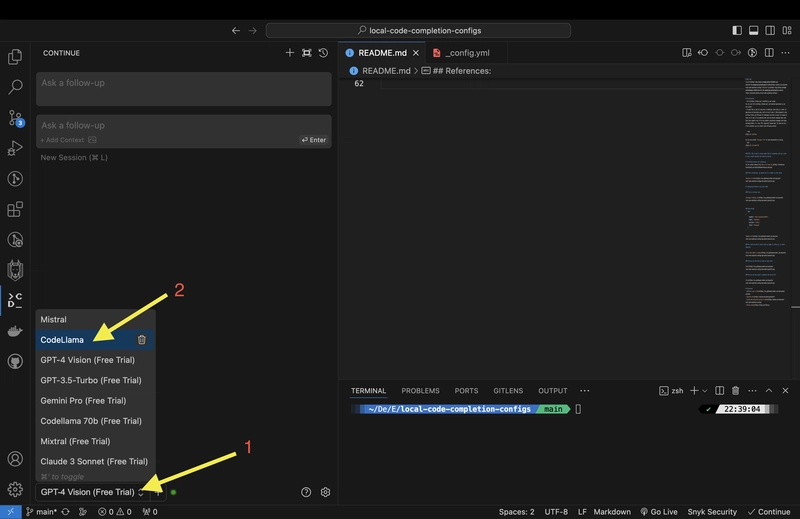

选择 CodeLlama,将其添加到配置中后,它将在下拉列表中可见

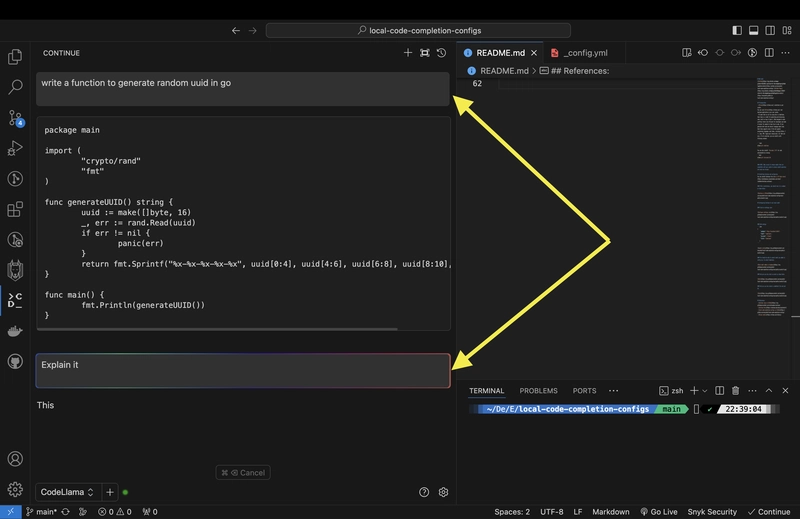

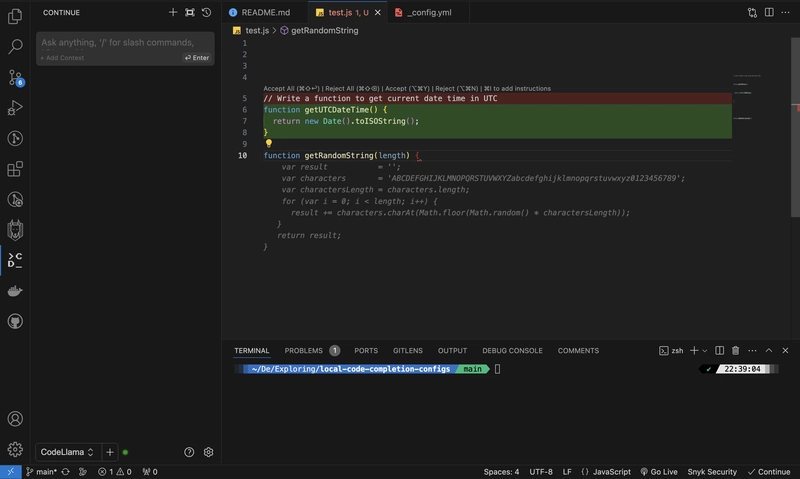

您也可以像下面这样正常聊天

您还可以选择一个代码块文件并询问AI:

后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com