Pipeline🛠️Repos 对决⚔️:Python 🐍 版

TL;DR

在数据工程和自动化不断发展的领域中,Python 已经见证了多个工作流编排工具的出现。在本文中,我将介绍 6 个 Python 库及其一些主要功能。

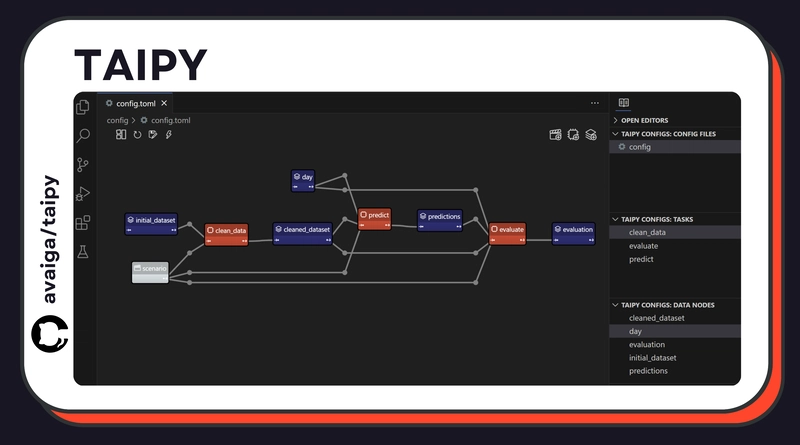

1. Taipy

Taipy 是一个开源 Python 库,用于构建可用于生产的前端和后端应用程序。

对于 Python 开发者来说,Taipy 是最易于使用的 Python 应用构建器之一,这得益于其图形化管道编辑器 Taipy Studio。

之后,您可以通过 Python 脚本轻松执行和编排管道。Taipy 的核心特性之一是每次管道执行都会被注册。

这使得轻松进行假设分析、KPI 监控、数据沿袭等操作成为可能。

🔑 特点:

- 图形管道编辑器

- 与 Taipy 前端功能集成,实现端到端部署

- 调度

- 管道版本控制

- 缓存等智能功能

您的支持意义重大🌱,并且确实在很多方面帮助了我们,比如写文章!🙏

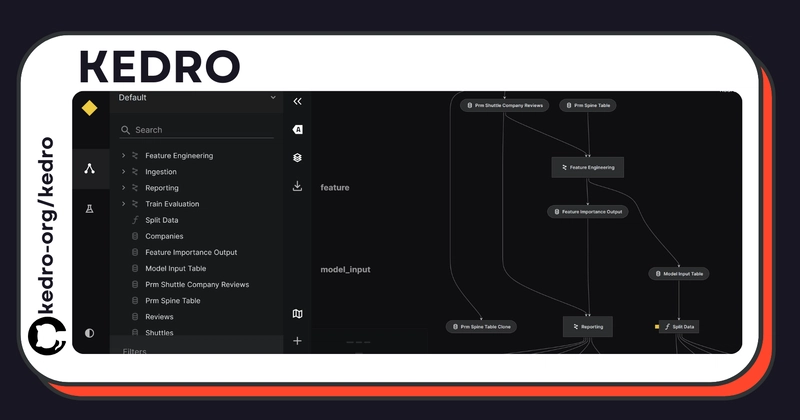

2.凯德罗

Kedro 是一个开源 Python 框架。

它提供了一个可用于生产环境的数据科学流程工具箱。

事实上,Kedro 可以轻松地与成熟的 Python 机器学习库集成,并提供了一种统一的端到端框架实现方法。

🔑 特点:

- 数据目录

- 笔记本集成

- 项目模板

- 坚持己见,因为它强制执行特定的惯例

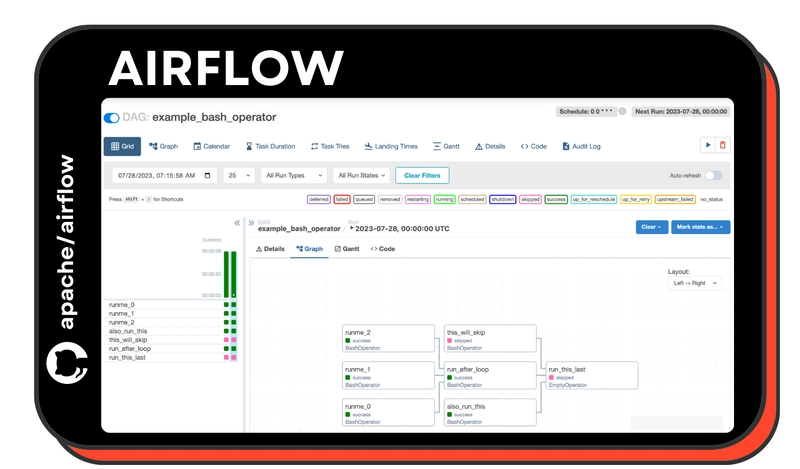

3.气流

Airflow 十多年来一直是管道领域的知名参与者。Airbnb

创建 Airflow 是为了应对数据处理和工作流需求方面的内部挑战。

这个强大的开源平台虽然学习难度较高,但功能丰富。

该平台允许用户通过构建 DAG(有向无环图)来创建和管理工作流。

🔑 特点:

- 基于DAG的定义

- 丰富的基于 Web 的监控 UI:DAG、故障、重试的可视化……

- 各种集成

- 动态任务执行和调度

- 由于其以 Python 为中心的特性,因此非常灵活。

- 强大的社区

4.级长

Prefect 是一个数据管道开发框架。Prefect

的战略定位是与 Airflow 直接竞争,其独特的特性基于简洁性、用户友好性和灵活性,使其脱颖而出。

如果您想要一款功能丰富、成熟且学习曲线比 Airflow 更低的产品,Prefect 是一个不错的选择。

🔑 特点:

- 控制面板

- 缓存

- 基于流程的结构

- 动态参数化和依赖管理

- 混合执行(本地/云)

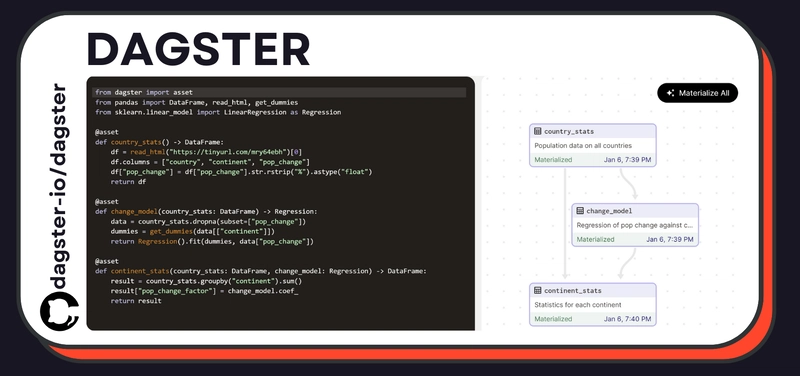

5.达格斯特

Dagster 是本汇编中较新的库之一,它是一个云原生数据管道编排工具,旨在统一数据集成、工作流编排和监控。

与其他工具相比,Dagster 更注重工作流创建和管理的 DataOps 方面。

🔑 特点:

- 声明式管道设置

- 固执己见的结构

- 版本控制

- 与 Hadoop 集成

- 全面的元数据跟踪

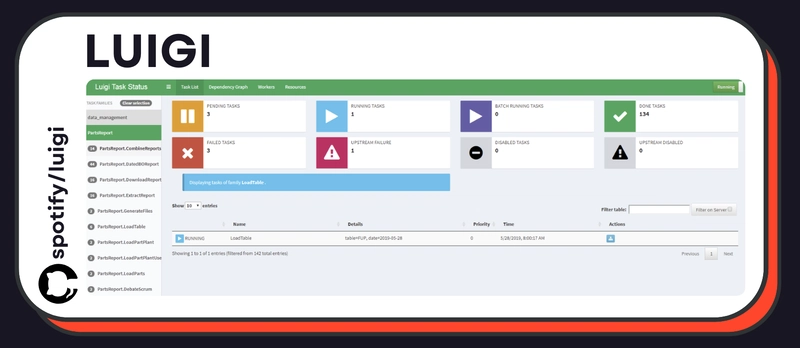

6.路易吉

Luigi 提供了一个数据处理管道框架。Spotify 大约与 Airflow 同时开发了这个库,用于处理其复杂的数据工作流和管道。Luigi 的

设计初衷是管理批处理作业的复杂通道。如果您正在寻找简单易用且能够快速上手的工具,Luigi 是一个不错的选择。

🔑 特点:

- 内置 Hadoop 支持

- 基于任务的工作流定义

- 依赖管理的中央调度程序

- 任务依赖关系的可视化

结论

随着 Python 工作流编排领域的不断发展,这些工具展现出主要的共同特征和独特的差异化优势。

所有这些工具的复杂程度各不相同,因此了解您的项目和团队的需求至关重要。

我建议您使用一些非常简单的示例来测试一些选项,以便直接了解每个框架的可用性。

希望您喜欢这篇文章!

我是一名新手作家,欢迎任何改进建议!

如果您有任何疑问,请随时联系我们。

文章来源:https://dev.to/taipy/the-pipeline-repos-showdown-python-edition-39i5 后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com