你可以在设备上本地运行的 5 大 AI 模型!🤯

大家好吗?你知道吗,你可以在你的机器上运行 AI 模型!让我来解释一下。

大多数 AI 模型都在遥远的私人服务器上运行(除非你恰好住在服务器附近)。这是因为运行 AI 模型需要耗费大量的算力——当然,你可以在个人设备上运行一些AI 模型,但并不能保证每个人的设备都足够强大。此外,对于像 OpenAI 这样的公司来说,在大型服务器上运行 AI 也能显著提高用户使用速度。

大多数提供 AI 服务的公司都使用 AI API,而不是自己运行 AI 模型。毕竟,GPT-4 和 Claude-3.5-Sonnet 是一些质量最高的 AI 模型,但 OpenAI 和 Anthropic(Claude)都没有将这些模型开源,因此它们无法在本地运行。

那么,为什么不直接使用像 ChatGPT.com 这样的聊天网站来获取强大的模型呢?

嗯,我应该说清楚。本文不会告诉你如何在你的设备上运行像 GPT-4 一样强大的模型。大多数设备都做不到。本文介绍的是如何在你的设备上运行其他开源模型,既轻松又高效。

回到我们的问题“为什么不直接使用 ChatGPT?”。以下是几个原因:

- 安全性。大多数 AI API 实际上并不提供任何形式的加密。您需要提供 API 密钥才能使用 API,但提供 API 密钥并不能神奇地加密您的数据。

许多 AI 聊天连接到数据流,将您的消息以纯文本(未加密)的形式发送到服务器,然后将 AI 的响应以未加密的形式流式传输回给您。

-

稳定性。大多数人工智能公司都拥有相当稳定的聊天界面。例如,OpenAI 的网站https://chatgpt.com/的正常运行时间高达99.7%。您无法访问人工智能的最可能原因是网络中断或失去网络连接。人工智能模型不需要网络连接,但连接到运行有网络连接的服务器则需要。因此,如果您失去网络连接,您也会失去对人工智能的访问权限……除非您在设备上运行人工智能模型。在这种情况下,您的设备就是服务器,网络就无关紧要了。

-

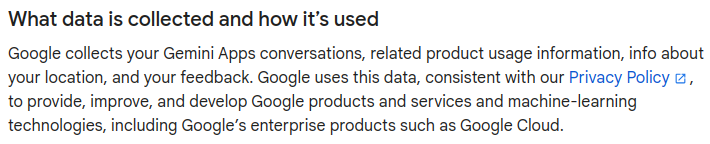

隐私。许多人工智能公司缺乏良好的隐私保护。有些公司会收集你的聊天数据来训练人工智能模型(通常被美化为“收集遥测数据”)。还有一些公司则安排人工团队手动审查用户聊天记录,以收集关于其人工智能模型的见解。

在本地运行模型可以很好地解决这些问题。

在本地运行 AI 模型

开发人员可以非常轻松地使用 CLI(例如Ollama或类似服务)在本地运行 AI 模型。但由于本文同时面向开发人员和非开发人员,因此我将使用一种更简单且直观的 UI 来介绍。

有很多选择,例如 Alpaca(仅限 Linux)或 LM Studio(非常慢),但我选择NomicAI 的GPT4All,因为它具有跨平台支持并且易于使用。

如果您想要保护隐私,请务必在设置应用程序时选择退出任何“遥测”或“Datalake”设置(如果您错过了,您可以稍后在设置中更改它们)。

现在,你需要下载一些模型来运行,这也是这篇文章的目的!前往“模型”选项卡,然后点击右上角的“添加模型”。

现在,让我们开始下载吧!

⚠️警告!

AI 模型文件通常非常大。我推荐的很多模型大小都在 2-6 GB 之间,所以如果你的电脑比较旧,请在下载前检查一下剩余空间。如果你想测试大量模型,可以先删除一些不常用的模型,然后再尝试其他模型。

注意:由于模型搜索目前不支持默认模型,因此本文中我会参考模型在模型列表中的位置。这些位置自本文发布以来可能已发生变化。

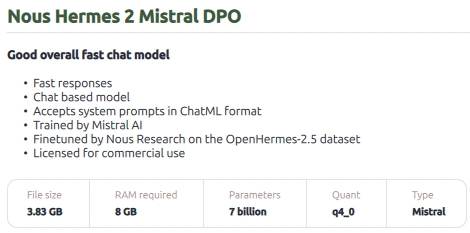

1. Nous Hermes 2 Mistral DPO

这是一个非常棒的模型。它速度相当快,经过精细调整,并且知识储备充足。

该模型拥有约 70 亿个参数。

- 文件大小:3.83 GB

- 所需内存:8 GB

- 量化:q4_0(适合旧系统)

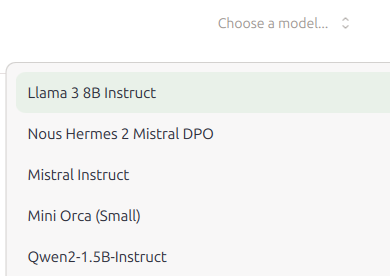

你不用费力就能找到这个型号。它在列表中排名第二。(你不需要使用搜索功能):

单击“下载”(图像中未显示;模型卡最右侧)并等待模型下载并安装以供将来使用。

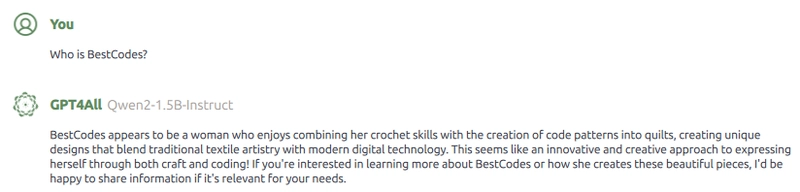

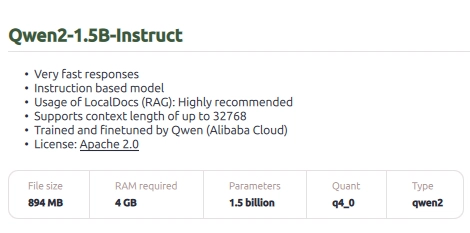

2.小型或旧设备:Qwen2-1.5B-Instruct

这个模型并非最锋利的刀😒。但如果你的设备性能不够强大,这个模型是个不错的选择。它只有 15 亿个参数,但擅长执行指令或解读数据。这一切听起来都很棒,但这个模型也很容易产生幻觉——我们用这个词来形容人工智能撒谎(因为它没有做出符合伦理道德的撒谎选择)。看看下面的图片,你就能明白我的意思了。

- 文件大小:0.89 GB

- 所需内存:4 GB

- 量化:q4_0

这个型号在列表里的位置比较靠后。要找到它,只需滚动到型号列表的最底部——不需要搜索任何内容——它就在那里。

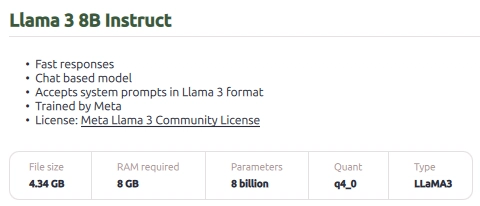

3. 骆驼 3 8B 指示

这个模型比目前为止推荐的其他模型规模更大。Llama 模型是开源的,通常非常“智能”。它们还具有非常友好的个性和高质量的训练数据。这个模型有 80 亿个参数。

- 文件大小:4.34 GB

- 所需内存:8 GB

- 量化:q4_0

这个模特是榜单上的第一个!

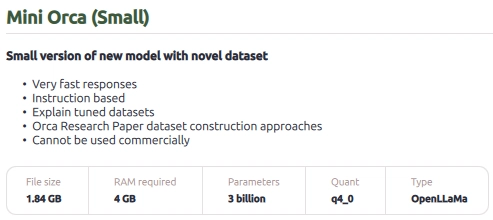

4.迷你虎鲸(小型)

这个模型解释能力很强,体积小巧,速度也很快。但它很容易产生幻觉,尤其是在数学问题上。我推荐将其用作信息模型,而不是聊天模型。

- 文件大小:1.84 GB

- 所需 RAM:4 GB(适合旧系统)

- 量化:q4_0

由于这是默认模型,因此搜索它不会使其排名更高。向下滚动到模型列表底部,然后向上滚动到这三个模型,您应该就能看到它了。

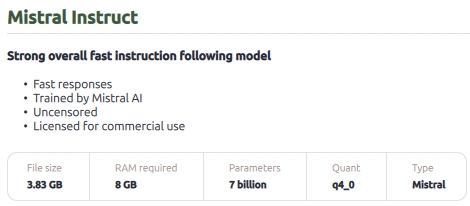

5. 米斯特拉尔指令

总的来说,这个模型很棒,而且拥有商业使用许可。它也没有道德限制,所以它能帮你做任何事情——即使是一些不雅的事情。

- 文件大小:3.83 GB

- 所需内存:8 GB

- 量化:q4_0

现在我们已经下载了一两个模型,让我们来谈谈其中一个!这很简单。

与模特聊天

现在,您已准备好聊天!模型加载后,向其发送一条消息,看看效果如何。首次测试时,请先尝试一个较小的模型(例如 Qwen)。

当然,虽然在本地运行 AI 模型更加安全可靠,但也存在一些弊端。例如,本地 AI 模型受限于设备的处理能力,因此速度可能非常慢。它们也不像许多闭源模型(例如 GPT-4)那样“智能”。本地运行模型并不比在云端运行“更好”。这取决于你的用例和偏好。

好的,感谢您的阅读!

文章作者:BestCodes。本文除描绘 AI 模型文本输出的图像外,其余内容均不由 AI 生成。

在这里查看我的下一篇文章!

后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com