‼️ 2025 年五大开源 LLM 评估框架 🎉🔥

TL:DR

1. DeepEval——法学硕士(LLM)的评估框架

2. MLFlow LLM Evaluate - LLM 模型评估

3. RAGA——检索增强生成 (RAG) 流程的评估框架

4.深度检查

5. Arize AI Phoenix

TL:DR

“我觉得 LLM 评估解决方案比 LLM 评估存在的问题还多”,一家财富 500 强公司的人工智能主管 Dylan 说道。

我完全同意——似乎每周都有一个新的开源项目试图做与现有 30 多个框架相同的事情。说到底,Dylan 真正想要的是一个框架、包、库,无论你怎么称呼它,它都能量化他想要投入生产的 LLM(应用程序)的性能。

因此,作为曾经处于 Dylan 境地的人,我整理了一份清单,列出了 2025 年存在的前 5 个 LLM 评估框架 :) 😌

让我们开始吧!

1. DeepEval——法学硕士(LLM)的评估框架

DeepEval 是你最喜欢的评估框架中最受欢迎的。它占据榜首的原因如下:

- 提供14 项以上 LLM 评估指标(涵盖 RAG 和微调用例),并根据 LLM 评估领域的最新研究进行更新。这些指标包括:

- G-评估

- 总结

- 幻觉

- 忠诚

- 语境相关性

- 答案相关性

- 情境回忆

- 语境精确度

- 拉加斯

- 偏见

- 毒性

大多数指标都是不言自明的,这意味着 DeepEval 的指标会直接告诉您为什么指标分数不能更高。

- 提供模块化组件,方便插拔和使用。您可以轻松混合搭配不同的指标,甚至可以根据需要使用 DeepEval 构建自己的评估流程。

- 将评估视为单元测试。通过与Pytest 集成,DeepEval 已成为大多数开发人员熟悉的完整测试套件。

- 允许您使用知识库作为上下文生成合成数据集,或从 CSV、JSON 或 Hugging face 加载数据集。

- 提供一个具有慷慨免费层的托管平台,以便在生产中运行实时评估。

通过 Pytest 集成:

from deepeval import assert_test

from deepeval.metrics import HallucinationMetric

from deepeval.test_case import LLMTestCase

test_case = LLMTestCase(

input="How many evaluation metrics does DeepEval offers?",

actual_output="14+ evaluation metrics",

context=["DeepEval offers 14+ evaluation metrics"]

)

metric = HallucinationMetric(minimum_score=0.7)

def test_hallucination():

assert_test(test_case, [metric])

然后在 CLI 中:

deepeval test run test_file.py

或者,不使用 Pytest(非常适合笔记本环境):

from deepeval import evaluate

...

evaluate([test_case], [metric])

2. MLFlow LLM Evaluate - LLM 模型评估

MLFlow 是一个模块化且简单的软件包,允许您在自己的评估流程中运行评估。它提供 RAG 评估和 QA 评估。

MLFlow 的优势在于其直观的开发者体验。例如,以下是使用 MLFlow 进行评估的步骤:

results = mlflow.evaluate(

model,

eval_data,

targets="ground_truth",

model_type="question-answering",

)

3. RAGA——检索增强生成 (RAG) 流程的评估框架

排名第三的是 RAGA,它是为 RAG 管道构建的。它们提供了 5 个核心指标:

- 忠诚

- 语境相关性

- 答案相关性

- 情境回忆

- 语境精确度

这些指标构成了 RAGA 的最终得分。DeepEval 和 RAGA 的实现非常相似,但 RAGA 的指标并非一目了然,这使得调试不理想的结果变得更加困难。

RAGAs 位列第三,主要是因为它也将最新研究融入其 RAG 指标中,使用简单,但由于其功能有限且作为框架缺乏灵活性,因此排名并不更高。

from ragas import evaluate

from datasets import Dataset

import os

os.environ["OPENAI_API_KEY"] = "your-openai-key"

# prepare your huggingface dataset in the format

# Dataset({

# features: ['question', 'contexts', 'answer', 'ground_truths'],

# num_rows: 25

# })

dataset: Dataset

results = evaluate(dataset)

4.深度检查

Deepchecks 的突出之处在于它更侧重于评估 LLM 本身,而不是 LLM 系统/应用程序。

由于其复杂的开发人员体验,它在列表中的排名并不高(认真的说,请尝试自己设置并告诉我效果如何),但它的开源产品是独一无二的,因为它主要关注仪表板和可视化 UI,这使得用户可以轻松地将评估结果可视化。

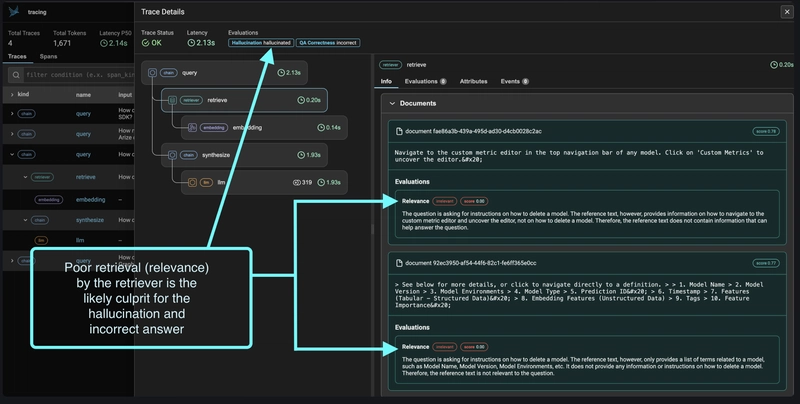

5. Arize AI Phoenix

最后一个是 Arize AI,它通过对 LLM 轨迹的广泛可观察性来评估 LLM 申请。然而,它的局限性非常大,因为它只提供了三个评估标准:

- 质量保证正确性

- 幻觉

- 毒性

以上就是 2025 年 GitHub 提供的顶级 LLM 评估框架列表。觉得我遗漏了什么吗?请在下方评论区留言告诉我!

感谢您的阅读,下次再见😊

文章来源:https://dev.to/guybuildingai/-top-5-open-source-llm-evaluation-frameworks-in-2024-98m 后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com