在 Visual Studio Code 中免费使用 Deepseek r1。

DeepseekR1 #AI #编码 #WindowsCMD”

随着大型语言模型 (LLM) 的快速发展,Deepseek-r1已成为当之无愧的有力竞争者。Deepseek-r1 在推理和代码生成方面的表现堪比 GPT-o1 模型,并利用 Transformer 和逻辑树推理来优化决策,为 AI 开发工具树立了新的标杆。

在使用过 Cursor 和其他付费代码助手等工具后,我很好奇 Deepseek-r1 在我的工作流程中会表现如何。这激发了我将其集成到我的环境中并评估其功能的旅程。

让我们开始吧🚀

步骤1:安装Ollama

首先,你需要一个 Ollama,它是一个允许你在本地运行 LLM 的平台。如果你还没有安装,请从 Ollama 的官方网站下载。按照安装说明操作,确保它在你的机器上顺利运行。

第 2 步:下载 Deepseek-r1

一旦 Ollama 启动并运行,就该将 Deepseek-r1 模型拉到本地环境了。在终端中运行以下命令:$ ollama pull deepseek-r1

下载后,您可以通过运行简单的 curl 命令来测试模型是否正常工作:$ curl http://localhost:11434/api/generate -d '{

"model": "deepseek-r1:latest",

"prompt": "Why is the sky blue?"

}'

如果模型设置成功,您将在终端中看到分块输出 - 表明 Deepseek-r1 已准备好运行。

步骤 3:安装 Continue.dev 扩展

在安装 Visual Studio Code 的前提下,前往扩展市场并安装 Continue.dev 扩展。此扩展弥合了 VS Code 与高级 AI 模型之间的差距,实现了编码辅助的无缝集成。

一旦安装完成,您就距离释放 Deepseek-r1 的强大功能更近了一步!

步骤4:在Continue.dev中配置Deepseek-r1

通过单击 VS Code 活动栏中的图标来打开 Continue.dev。

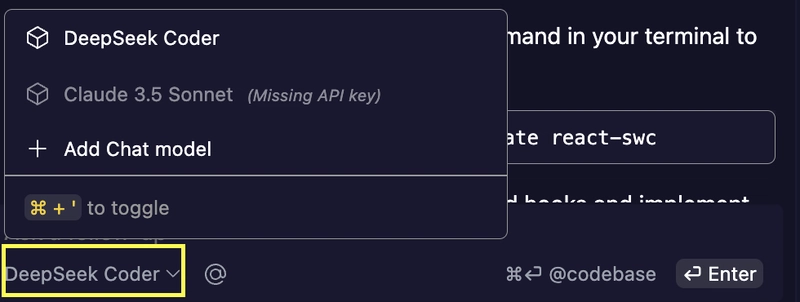

在聊天窗口中,找到左下角的模型选择按钮。

单击按钮打开下拉菜单。

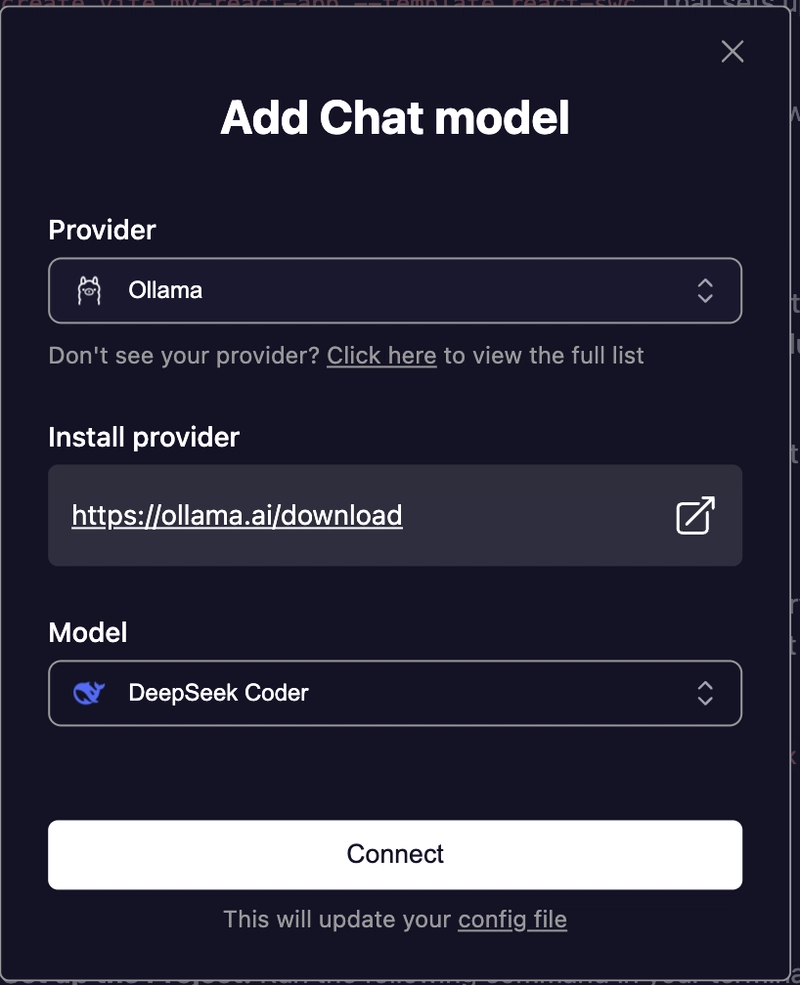

从菜单中选择 Ollama 作为平台。

选择 Ollama 后,您将看到本地环境中所有可用的模型。从列表中选择 Deepseek-r1。

此时,Continue.dev 配置为通过 Ollama 使用 Deepseek-r1。

准备编码!

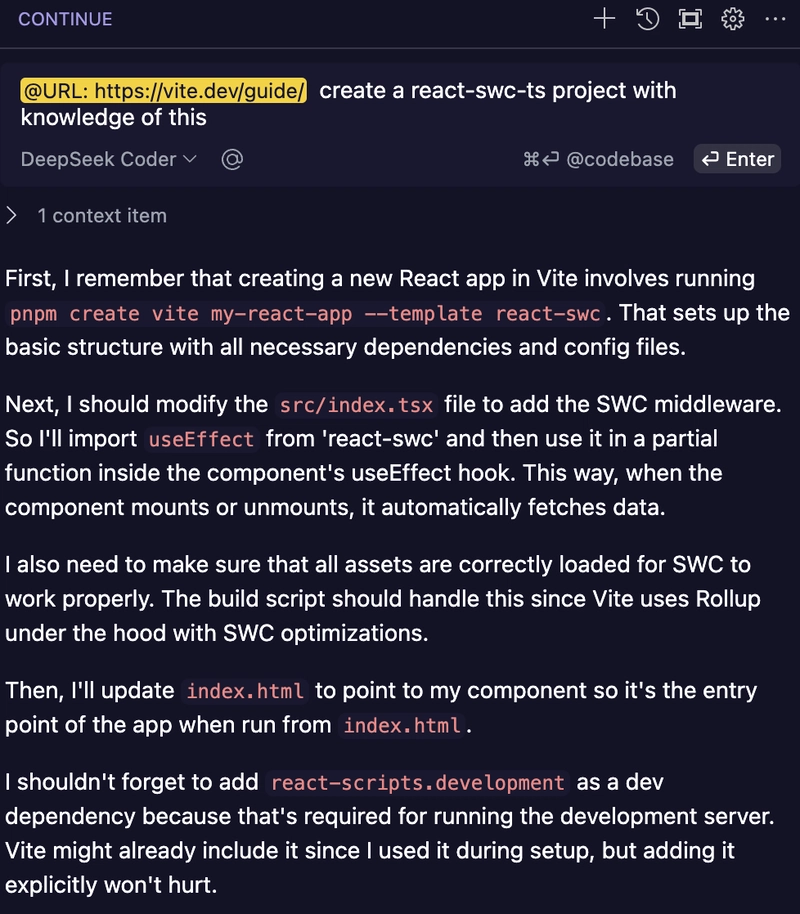

一切设置完毕后,您现在可以直接在 VS Code 中充分利用 Deepseek-r1 的高级推理和代码生成功能。Continue.dev 还支持其他上下文感知功能,从而提升开发体验:

自动完成:获取完成代码行或代码块的精准建议。

代码重构:高亮显示部分代码,并请求优化或重写。

代码解释:选择任意代码片段,让 AI 为您分解。

以下是工作流程的简要介绍:

为什么选择 Deepseek-r1?

推理卓越:逻辑树推理确保更智能、更优化的决策。Transformer

Power:在代码生成任务中提供强大的性能。

本地执行:在本地运行模型,以获得更好的隐私保护和更快的响应速度。

通过将 Deepseek-r1 与 Continue.dev 集成,您可以解锁强大的开发工作流程,以满足您的特定需求。

为更智能的编码干杯!🥂

文章来源:https://dev.to/lunaticprogrammer/using-deepseek-r1-in-visual-studio-code-for-free-2279 后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com