在 Google Colab 中使用 Hugging 人脸模型:初学者指南

本指南将指导您在 Google Colab 中使用 Hugging Face 模型。我们将涵盖从设置使用 GPU 的 Colab 环境到运行您的第一个 Hugging Face 模型的所有内容。Hugging Face提供预先训练的模型,让您无需从头开始即可轻松构建强大的自然语言处理 (NLP) 和机器学习应用程序。

预备知识

了解以下内容会很有帮助:

- Python:熟悉Python语法。

- 机器学习:了解分类、文本生成和嵌入等机器学习任务。

- Google Colab:使用 Colab 笔记本的基本技能。

- Hugging Face 基础知识:了解变压器、管道和 Hugging Face Hub 等概念。

步骤 1:使用 GPU 设置 Google Colab

运行 Hugging Face 模型(尤其是基于 Transformer 的模型)可能会占用大量资源,因此在 Colab 中设置 GPU 将有助于加快速度。

-

打开一个新的 Colab 笔记本:

- 转到Google Colab,创建一个新的笔记本,并根据需要命名。

-

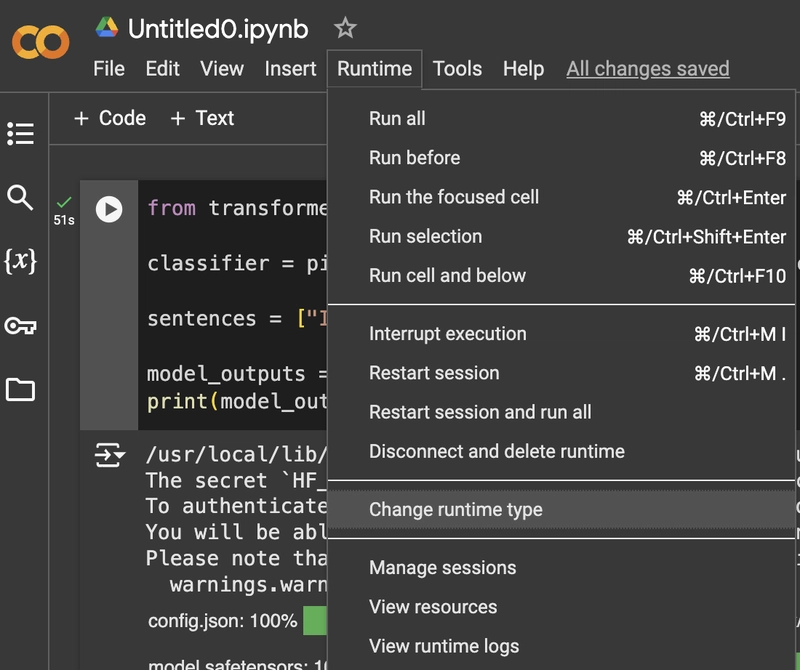

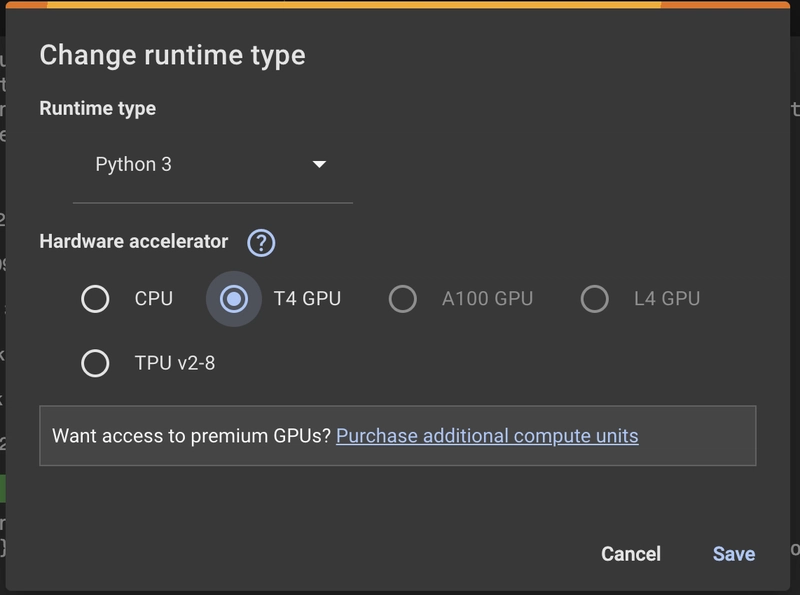

将运行时更改为 GPU:

- 在顶部菜单中,转到运行时>更改运行时类型。

- 将硬件加速器设置为GPU并单击保存。

-

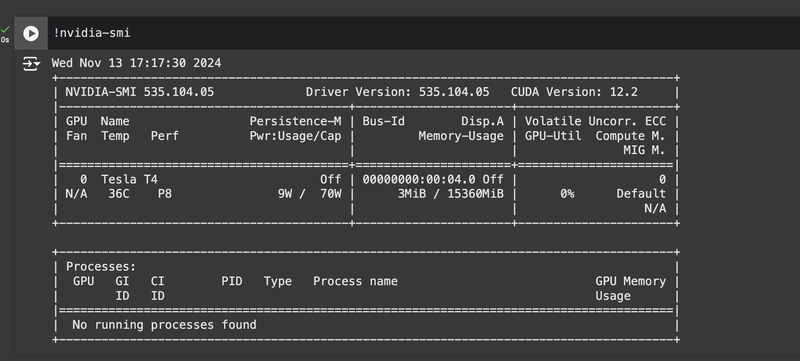

验证 GPU:

- 要确认您的 GPU 设置,请运行以下命令:

!nvidia-smi

- 这将显示有关您的会话可用的 GPU 的信息。

步骤 2:安装 Hugging Face 库

要访问 Colab 中的 Hugging Face 模型,您需要安装 Hugging Facetransformers库,其中包括预先训练的模型和管道。

-

安装 Hugging Face Transformers 库:

- 在新单元中,运行以下命令:

!pip install transformers -

安装其他可选库(如果需要):

- 如果您的任务需要数据集或标记器,您可以从 Hugging Face 安装其他库:

!pip install datasets !pip install tokenizers

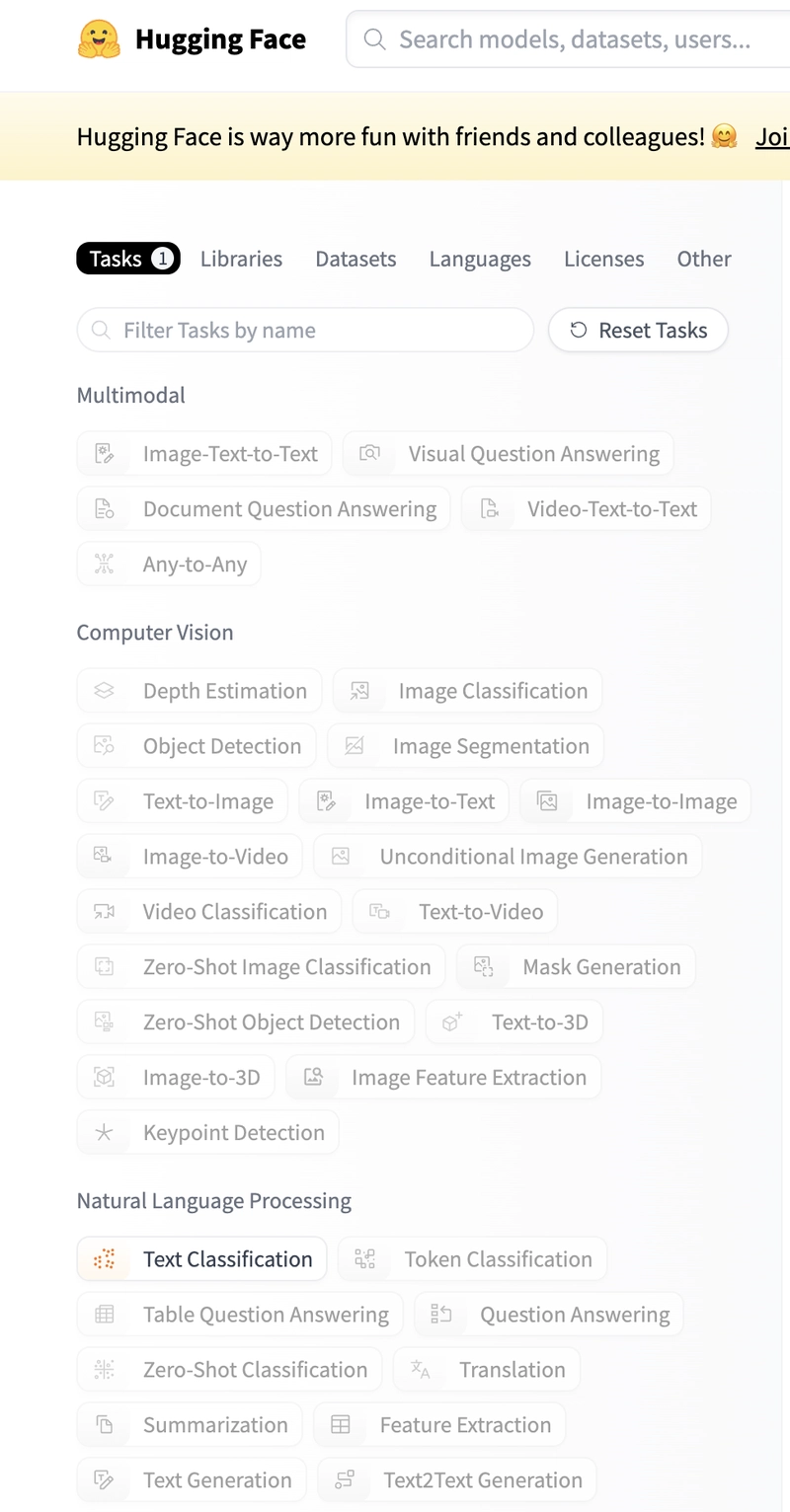

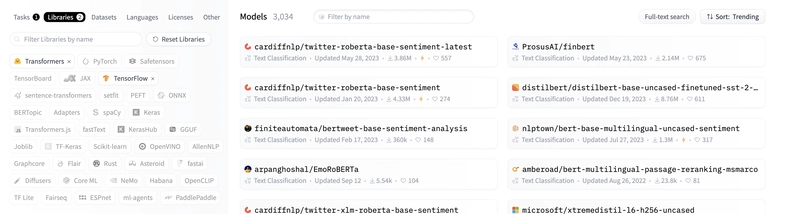

步骤 3:在 Hugging Face Hub 上探索并选择模型

Hugging Face 提供了大量可用于各种任务的模型库。以下是如何查找和选择模型的方法:

-

访问 Hugging Face Hub:

- 前往Hugging Face Hub并按任务浏览模型,例如文本分类、摘要或图像处理。

-

按任务和模型过滤:

- 使用“任务”选项卡根据您的任务要求(例如,情感分析、文本生成)过滤模型。

- 您还可以按特定类别(如 NLP、计算机视觉和音频)探索模型。

3)选择型号并复制使用代码:

- 每个模型都有一个“使用”部分,其中包含使用该模型的示例代码。选择一个模型并将此代码复制到您的 Colab 笔记本中,即可轻松进行设置。

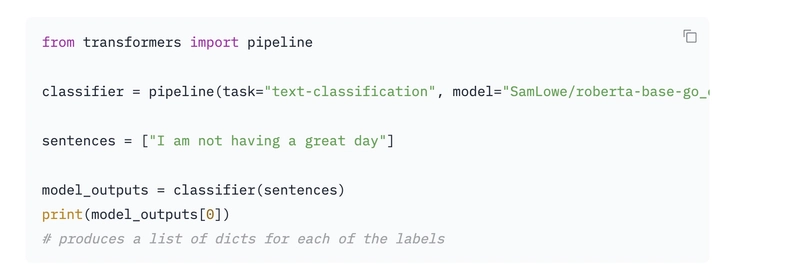

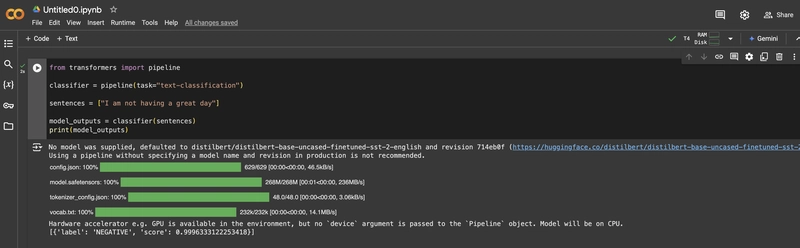

步骤 4:在 Google Colab 中使用该模型

选择模型后,您可以使用提供的代码片段直接在 Colab 中加载并运行该模型。以下是设置分类器模型的分步示例。

-

导入管道功能:

- Hugging Face 中的函数

pipeline可以通过指定任务类型来轻松加载模型。在 Colab 笔记本中运行以下代码:

from transformers import pipeline - Hugging Face 中的函数

-

初始化模型管道:

- 在这里,我们将使用以下内容初始化情绪分析模型

pipeline:

# Set up a sentiment-analysis pipeline classifier = pipeline("sentiment-analysis") - 在这里,我们将使用以下内容初始化情绪分析模型

- 这将创建一个

classifier可用于对文本输入进行分类的对象。如果您未指定模型名称,pipeline则将为该任务加载默认模型。

-

在示例文本上运行模型:

- 现在,让我们对一些文本使用分类器:

result = classifier("I love using Hugging Face models in Colab!") print(result)

- 输出将显示分类标签(例如,POSITIVE 或 NEGATIVE)以及置信度分数。

-

明确指定模型(可选):

- 要使用 Hugging Face Hub 中的特定模型,请将模型名称作为参数传递:

classifier = pipeline("sentiment-analysis", model="distilbert-base-uncased-finetuned-sst-2-english")

- 如果您有首选的架构或语言支持,指定模型会很有用。

步骤5:尝试其他任务和模型

Hugging Face 模型不仅限于情绪分析。您可以通过更改pipeline函数中的任务名称来尝试其他任务:

- 文本生成:

generator = pipeline("text-generation", model="gpt2")

result = generator("Once upon a time,")

print(result)

- 翻译:

translator = pipeline("translation_en_to_fr")

result = translator("I love coding in Python!")

print(result)

- 问答:

question_answerer = pipeline("question-answering")

result = question_answerer({

"question": "What is the capital of France?",

"context": "Paris is the capital of France."

})

print(result)

附加提示

- 探索拥抱脸教程:有关特定任务的指南,请查看拥抱脸任务页面。

-

使用大型语言模型 (LLM) 进行实验:您可以在GitHub上找到精选的开源 LLM 列表,在那里您可以为您的任务发现更强大的模型。

-

用作 API 端点:

使用Python FastAPI服务器或Node.js Express服务器,您可以创建一个使用 Hugging Face 模型的 API。以下是每种方法的简要回顾: -

Python FastAPI:

- 直接使用 Hugging Face 的

transformers库。 - 无需依赖 Hugging Face Inference API 即可提供模型灵活性。

- 如果您熟悉 Python 并需要自定义设置,这是理想的选择。示例->

- 直接使用 Hugging Face 的

-

Node.js Express:

- 使用 Hugging Face Inference API 进行推理。

- 无需安装大型模型文件;非常适合轻量级设置。

- 如果您喜欢使用 JavaScript 和 Node.js,那么这是一个很好的选择。示例->

这两种方法都允许您将 Hugging Face 强大的模型集成到您的应用程序中,从而实现文本生成、情感分析、图像分类等任务!

按照以下步骤,您只需极少的设置即可在 Google Colab 上运行各种 Hugging Face 模型。此pipeline功能简化了初学者的模型使用,让您专注于实验 NLP 和 ML 模型,快速获得令人印象深刻的结果。

后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com