本地法学硕士的兴起?

在不久的过去,涉足生成式人工智能技术意味着严重依赖专有模型。流程很简单:拿到 OpenAI 的密钥,就可以开始使用,尽管要遵循按需付费的模式。然而,随着 ChatGPT 的推出,这一障碍开始瓦解,它为任何在线用户敞开了大门,让他们可以不受财务限制地体验这项技术。

然而,2023年标志着一个激动人心的转折点,数字领域开始涌现出大量开源模型。回顾Sam Altman的一次采访,他曾预测未来将由少数几个模型主导,创新主要通过对这些巨头模型的迭代来实现,但这一预测似乎与事实不符。尽管GPT-4继续在大型语言模型(LLM)领域占据主导地位,但开源社区正在迅速发展壮大。

在众多蓬勃发展的开源项目中, Ollama尤其吸引了我的注意。与最初的印象相反,Ollama 并非只是众多模型中一个被随意丢弃的。相反,它是一款革命性的应用程序,旨在让用户能够直接在本地设备上下载并运行热门模型,从而让尖端人工智能技术的获取更加民主化。

有什么炒作?

好吧,我不只是告诉你,还想给你看一些东西。

将Ollama 下载到您的本地机器上。

完成后,尝试与这里的模特聊天:

如果遇到 CORS 错误,请运行以下命令:

OLLAMA_ORIGINS=* ollama serve

这样,您现在就可以在文章中与在本地机器上运行的 Llama2 模型进行聊天。

看一下代码——这只是一个简单的获取请求:

fetch("http://localhost:11434/api/generate", {

method: "POST",

headers: {

"Content-Type": "application/json",

},

body: JSON.stringify({

model: "llama2",

prompt: document.querySelector("input").value,

stream: true,

}),

});

llama2 并非唯一可用的模型。他们的模型库中有很多模型可供下载并在本地运行。您只需model: "llama2"在获取请求中更改模型名称即可。

真有趣!现在你的电脑上(离线)就有强大的模型运行了。

令人惊奇的是,你可以在任何拥有 8GB RAM(7B 型号)的机器上运行它。要运行更大的型号,你可能需要更多 RAM。

这如何改变一切?

OpenAI 和 Cohere 等主要参与者提供类似的 API,但它们总是需要付出成本,更不用说隐私问题了。

当然,在线托管和运行这些模型是一种选择,但想象一下离线操作这些模型所带来的可能性。

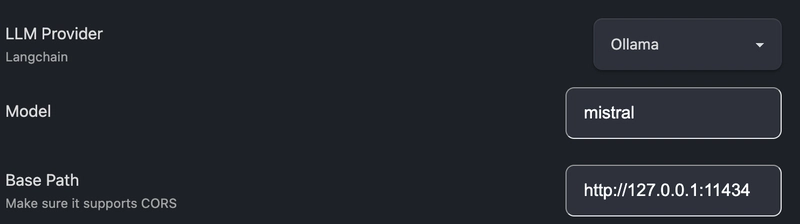

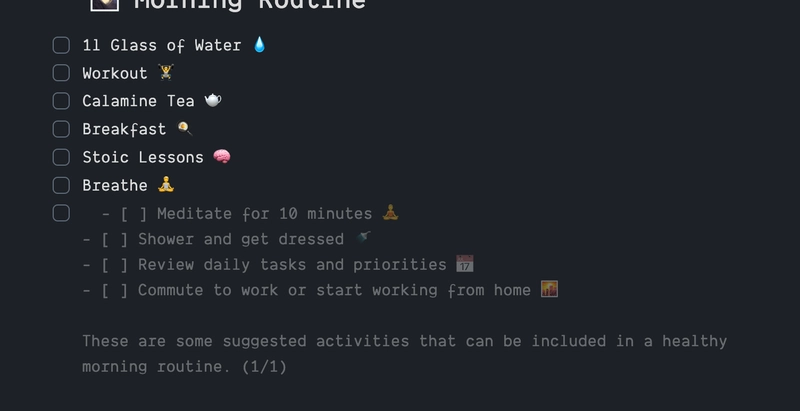

例如,看看这个可以在 Obsidian 中使用的插件Text Gen。你可以在设置中将 Ollama 设置为你的 LLM 提供程序,并指定要使用的模型,如下所示:

瞧,

现在,Obsidian 中就有了自动完成功能,就是这样。

或者,您可以使用Continue来替代 GitHub 的 Copilot。只需下载带有 Ollama 的codellama,选择 Ollama 作为您的 LLM 提供商,然后,您的计算机上就有一个本地 Copilot 在运行了。

我的意思是,现在你可以这样做......

无需网络。零成本。

对 Ollama 上更多酷炫的实验感兴趣吗?以下是 10 个:

和...

想象一下,在你的项目中添加一个 Ollama 提供商。如果用户安装了 Ollama,你就可以免费为用户提供强大的 AI 功能。

结论

当然,这仅仅是个开始。Ollama 的最新版本包含一些非常酷的模型,例如Gemma,这是谷歌 DeepMind 构建的轻量级、最先进的开放模型系列,已于上周发布。

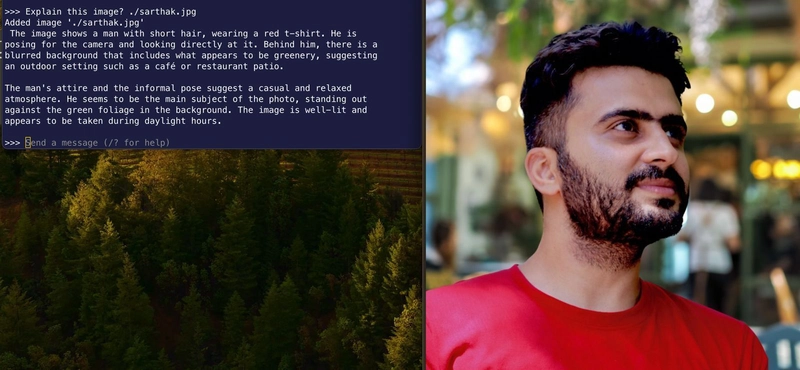

或者考虑LLava模型,它可以赋予您的应用程序计算机视觉功能。

我想说,Ollama 只是一个开始,但它并非唯一一个秉持这一理念的项目。还有一个名为WebLLM的更老的项目,它可以将开源模型下载到浏览器缓存中,方便用户离线使用。

那么,它接下来会走向何方?没人知道。但如果一定要我猜的话,我会说这些机型很快就会成为操作系统的一部分。我的意思是,它们几乎必须如此。苹果可能已经在开发操作系统了——谁知道呢?他们的机器肯定配备了所需的强大芯片。🤷♂️

离线 LLM(大型语言模型)将是未来的发展方向,尤其是在隐私和安全问题日益受到关注的情况下。不久的将来,甚至你的移动设备也将配备 LLM。问题是,我们将如何使用它们?相信我,聊天并非唯一的用例;未来还会有更多用例。像三星 Galaxy S24 Ultra 这样的最新移动设备已经开始利用 AI 应用,并且它们与整个操作系统的集成度相对较高。我猜想,随着时间的推移和本地 LLM 功能的不断增强,这将以更新颖(且更安全)的方式进一步增强我们的移动设备。

我鼓励你尝试一下这项技术。你可以访问Ollamahub查找不同的模型文件和提示模板,为你的本地法学硕士课程增添一些特色。

考虑使用像LangChain这样的库来进一步构建这项技术,添加长期记忆和上下文感知功能。您甚至可以使用Flowise在本地尝试低代码设置。

这难道不令人兴奋吗?我很想听听你的想法!🌟 有没有一些很酷的想法浮现在你的脑海里?欢迎在下方评论区分享你的想法——我洗耳恭听!

如果你迫不及待地想聊聊某个潜在想法,或者只是需要一些指导,不妨在推特上@sarthology留言给我?我迫不及待地想和你联系。期待下次再见!💬✨

鏂囩珷鏉ユ簮锛�https://dev.to/sarthology/rise-of-local-llms--21pe 后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com