25 个开源 AI 工具,助您缩短一半的开发时间

每个机器学习/人工智能项目的利益相关者都需要专门的工具,以便有效地管理机器学习/人工智能项目的各个阶段,从数据准备、模型开发到部署和监控。他们倾向于使用专门的开源工具,因为这些工具对人工智能项目的进步、开发和便捷性起到了重要的催化作用。因此,多年来涌现出众多开源人工智能工具,使得从众多可用工具中进行选择变得颇具挑战性。

本文重点介绍了选择开源工具时需要考虑的一些因素,并介绍了可用于 AI 项目的 25 个开源选项。

为人工智能项目选择开源工具

开源工具模型使公司能够开发各种机器学习工具,以帮助您处理 AI 项目中的特定问题。AI 工具领域已经充斥着各种工具,而过多的选项使得工具选择变得困难。其中一些工具甚至提供类似的解决方案。您可能仅仅因为工具提供的诱人功能而倾向于采用它们。但是,在选择工具之前,您还应该考虑其他关键因素,其中包括:

- 受欢迎程度

- 影响

- 创新

- 社区参与

- 与新兴人工智能趋势的相关性。

受欢迎程度

广泛采用的工具通常意味着积极的开发、定期的更新和强大的社区支持,以确保可靠性和长久性。

影响

一个具有解决痛点、提供可衡量改进、提供长期项目可持续性以及适应人工智能项目问题不断变化的需求的记录的工具是衡量利益相关者有兴趣利用的有影响力工具的一个很好的标准。

创新

采用更多现代技术并提供独特功能的工具体现了对持续改进的承诺,并有可能推动进步并开启新的可能性。

社区参与

积极的社区参与可以促进协作、提供支持并确保工具的持续相关性和改进。

与新兴人工智能趋势的相关性

与 LLM 等新兴趋势相一致的工具使组织能够利用最新的功能,确保他们的项目始终处于创新的前沿。

适用于你的 AI 项目的 25 个开源工具

基于这些因素,这里有 25 种工具可供您和您团队中的不同利益相关者在 AI 项目的各个阶段使用。

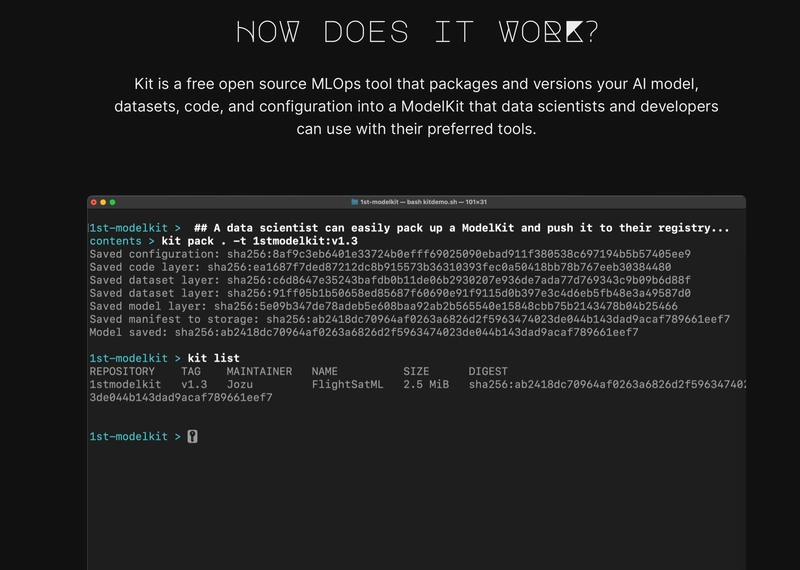

1. KitOps

机器学习开发生命周期涉及多个利益相关者,需要在 AI 项目的各个阶段使用不同的 MLOps 工具和环境,因此很难保证有组织、可移植、透明和安全的模型开发流程。

这为模型开发过程中模型谱系中断以及意外或恶意篡改或修改带来了机会。由于模型内容是“黑匣子”,缺乏高效的存储和谱系,因此在模型开发、预发布、部署和退役流程中,我们无法知晓模型或模型制品的内容是否被篡改。

KitOps为 AI 项目利益相关者提供了一个名为 ModelKit 的安全包,他们可以使用它在整个 ML 开发生命周期中共享和管理模型、代码、元数据和工件。

ModelKit 是一个不可变的 OCI 标准构件,它利用常见的容器原生技术(类似于 Docker 和 Kubernetes),使其能够使用通用的软件工具和环境在各个利益相关者之间无缝互操作和移植。作为一个不可变的包,ModelKit 具有防篡改功能。这种防篡改特性为利益相关者提供了一个版本控制系统,该系统可以跟踪整个机器学习开发和部署流程中对其任何内容(即模型、代码、元数据和构件)的每次更新。

2. 朗链

LangChain是一个机器学习框架,它使机器学习工程师和软件开发人员能够快速构建端到端的 LLM 应用程序。其模块化架构使他们能够轻松地混合搭配其丰富的组件套件,以创建自定义的 LLM 应用程序。

LangChain 通过其由LangSmith、LangServe和LangGraph组成的互联生态系统,简化了 LLM 应用程序的开发和部署阶段。它们共同帮助机器学习工程师和软件开发人员高效地构建稳健、多样化且可扩展的 LLM 应用程序。

LangChain 使没有强大 AI 背景的专业人士能够轻松构建具有大型语言模型 (LLM) 的应用程序。

3.厚皮动物

Pachyderm是一个数据版本控制和管理平台,使工程师能够自动化复杂的数据转换。它使用一个数据基础架构,通过数据驱动的版本控制管道提供数据沿袭。版本控制的管道会根据数据的变化自动触发。它会跟踪对数据的每一次修改,从而可以轻松复制之前的结果并使用各种管道版本进行测试。

Pachyderm 的数据基础设施提供了具有版本控制和谱系的“数据感知”管道。

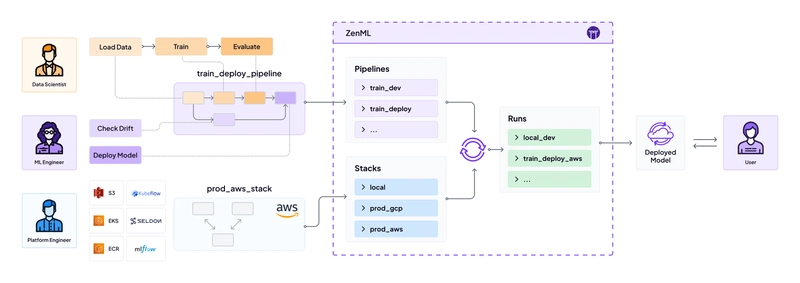

4. ZenML

ZenML是一个结构化的 MLOps 框架,它抽象了 MLOps 管道的创建,使数据科学家和 ML 工程师能够专注于数据预处理、模型训练、评估和部署的核心步骤,而不会陷入基础设施细节。

ZenML 框架抽象了 MLOps 基础设施的复杂性并简化了 MLOps 的采用,使 AI 项目组件可访问、可重用和可复制。

5. 级长

Prefect是一个用于机器学习流水线的 MLOps 编排框架。它使用任务(单个工作单元)和流程(任务序列)的概念来构建 ML 流水线,用于运行 ML 代码的不同步骤,例如特征工程和训练。这种模块化结构使 ML 工程师能够简化复杂 ML 工作流的创建和管理。

Prefect 简化了数据工作流管理、强大的错误处理、状态管理和广泛的监控。

6.雷

Ray是一个分布式计算框架,它使数据科学家和机器学习工程师能够在模型开发过程中轻松扩展机器学习工作负载。它简化了计算密集型工作负载(例如加载和处理大量数据或深度学习模型训练)从单台机器到大型集群的扩展。

Ray 的核心分布式运行时,可以轻松扩展 ML 工作负载。

7. Metaflow

Metaflow是一款 MLOps 工具,它通过统一的 API 来提高数据科学家和机器学习工程师的工作效率。该 API 提供了一种代码优先的方法来构建数据科学工作流,并包含了数据科学家和机器学习工程师执行 AI 项目(从原型到生产)所需的整个基础架构堆栈。

8. MLflow

MLflow帮助数据科学家和工程师管理模型开发和实验。它简化了从实验到部署的整个模型开发生命周期。

MLflow 的主要功能包括:

MLflow 跟踪:它提供 API 和 UI,用于在训练机器学习模型时记录和查询实验、参数、代码版本、指标和输出文件。记录结果后,您可以比较多次运行。

MLflow 项目:它提供了一种标准的可重用格式来打包数据科学代码,并包含 API 和 CLI,用于运行项目并将其链接到工作流中。任何 Git 存储库/本地目录都可以视为 MLflow 项目。

MLflow 模型:它提供了一种标准格式,可以在不同的服务环境中部署 ML 模型。

MLflow 模型注册表:它为您提供一个集中式模型存储、一组 API 和 UI,以便您协作管理模型的整个生命周期。它还支持模型谱系(从模型实验和运行)、模型版本控制和开发阶段转换(即将模型从暂存环境迁移到生产环境)。

9.Kubeflow

Kubeflow是 Kubernetes 的 MLOps 工具包。它旨在简化 Kubernetes 集群上 ML 工作流的编排和部署。其主要目的是使复杂的 ML 系统能够更轻松地扩展和管理,并使其可移植且可扩展到不同的基础架构。

Kubeflow 是 MLOps 领域的关键参与者,它推出了一个强大而灵活的平台,用于在 Kubernetes 上构建、部署和管理机器学习系统。这个用于开发、部署和管理机器学习模型的统一平台,促进了数据科学家、机器学习工程师和 DevOps 团队之间的协作。

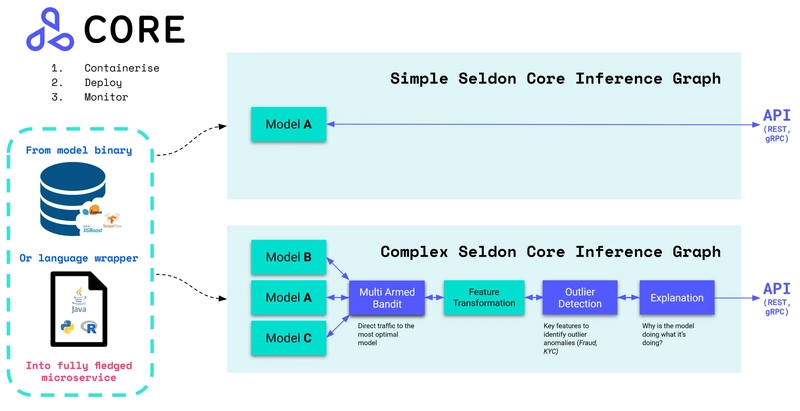

10. Seldon 核心

Seldon core是一个 MLOps 平台,通过将机器学习模型(TensorFlow、PyTorch、H2o 等)或语言包装器(Python、Java 等)转换为可用于生产的 REST/GRPC 微服务,简化了机器学习模型的部署、服务和管理。您可以将其视为预打包的推理服务器或自定义服务器。Seldon core 还支持这些服务器的容器化,并提供开箱即用的功能,例如高级指标、请求日志记录、解释器、异常值检测器、A/B 测试和金丝雀测试。

Seldon Core 的解决方案专注于模型管理和治理。它面向机器学习 (ML) 和 DevOps 工程师,尤其适用于模型部署和监控,而非小型数据科学团队。

11.DVC(数据版本控制)

为机器学习项目实施版本控制需要管理代码、数据集、机器学习模型、性能指标以及其他与开发相关的构件。其目的是将软件工程的最佳实践(例如版本控制和可复现性)引入数据科学和机器学习领域。DVC使数据科学家和机器学习工程师能够像 Git 跟踪代码一样跟踪数据和模型的更改,从而使其能够在任何 Git 存储库上运行。它还支持对模型实验的管理。

DVC 与 Git 的集成使得将软件工程原理应用于数据科学工作流程变得更加容易。

12. 显然人工智能

EvidentlyAI是一个可观测性平台,旨在分析和监控生产级机器学习 (ML) 模型。其主要目的是帮助 ML 从业者了解并维护其部署模型的长期性能。Evidently 提供了一套全面的工具,用于跟踪关键模型性能指标,例如准确率、精确率、召回率和漂移检测。它还使利益相关者能够生成交互式报告和可视化效果,从而轻松识别问题和趋势。

13. 法师人工智能

Mage AI是一个数据转换和集成框架,它允许数据科学家和机器学习工程师构建和自动化数据管道,而无需大量编码。数据科学家可以轻松地在 Mage 笔记本中连接到数据源、提取数据并构建可用于生产环境的数据管道。

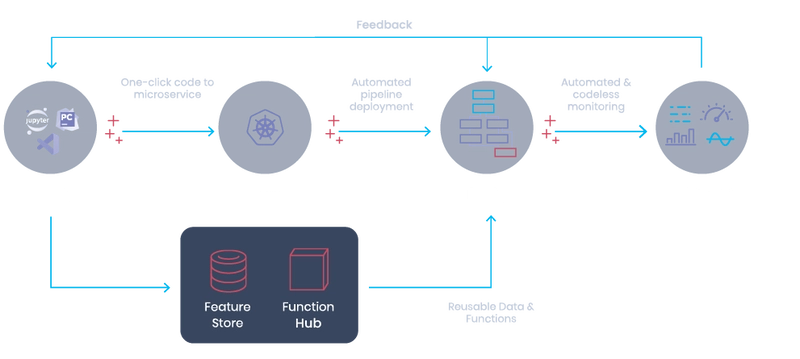

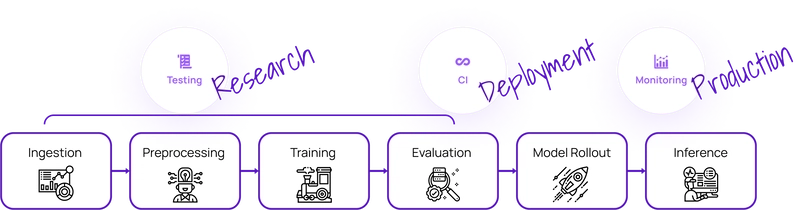

14. 机器学习运行

ML Run提供了一种无服务器技术,用于编排端到端 MLOps 系统。该无服务器平台将 ML 代码转换为可扩展且可托管的微服务。这简化了数据科学家、ML、软件以及 DevOps/MLOps 工程师在整个机器学习 (ML) 生命周期中跨不同环境的开发和管理流程。

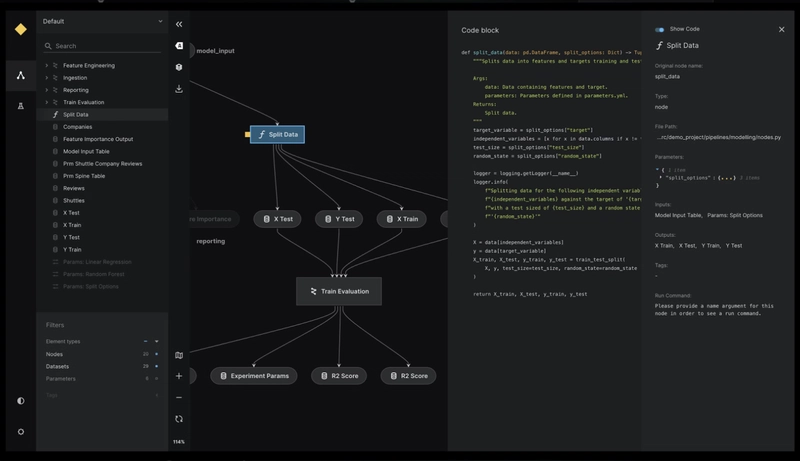

15.凯德罗

Kedro是一个机器学习开发框架,用于创建可复现、可维护、模块化的数据科学代码。Kedro 通过数据抽象和代码组织提升 AI 项目开发体验。它使用轻量级数据连接器,提供集中式数据目录,用于在整个项目中管理和跟踪数据集。这使得数据科学家能够专注于通过 Kedro 的数据管道构建生产级代码,并使其他利益相关者能够在系统的不同部分使用相同的管道。

Kedro 专注于数据管道开发,为数据科学家实施 SWE 最佳实践。

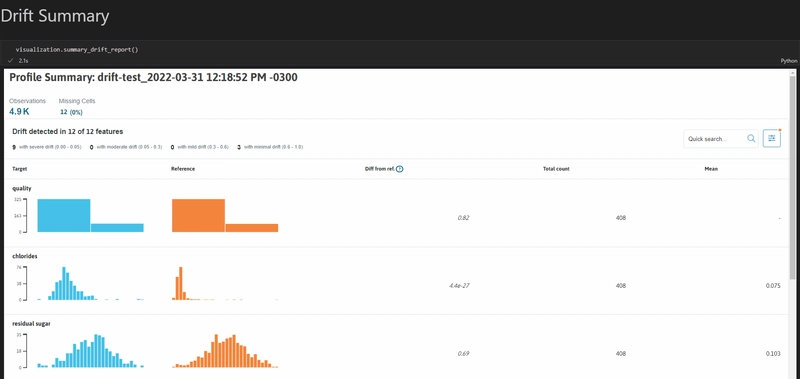

16. WhyLogs

WhyLabs 的WhyLogs是一个专为机器学习 (ML) 模型和数据管道设计的开源数据日志库。其主要目的是提供对数据质量和模型性能随时间变化的可见性。

借助 WhyLogs,MLOps 工程师可以高效地生成数据集的简洁摘要(称为配置文件),以捕捉重要的统计属性和特征。这些配置文件跟踪数据集随时间的变化,有助于检测数据漂移——这是导致模型性能下降的常见原因。它还提供可视化数据集配置文件中关键摘要统计数据的工具,从而轻松理解数据分布并识别异常。

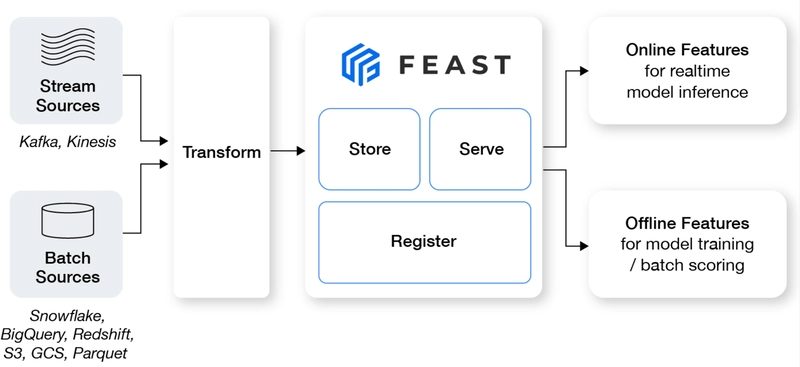

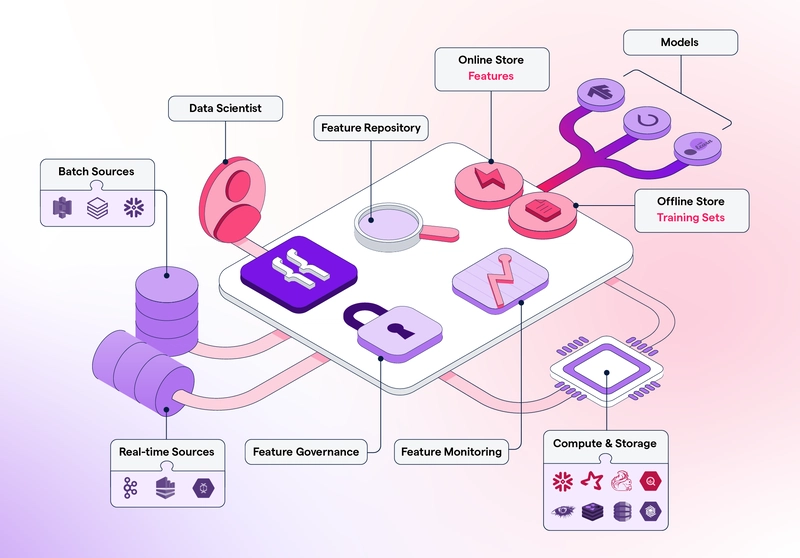

17.盛宴

在孤岛中(即从不同位置)定义、存储和访问用于模型训练和在线推理的特征可能会导致特征定义不一致、数据重复、数据访问和检索复杂等。Feast解决了利益相关者在开发和生产环境中管理和提供机器学习 (ML) 特征的挑战。

Feast 是一个特征存储,它弥合了数据与机器学习模型之间的差距。它提供了一个用于定义特征模式的集中式存储库,确保不同团队和项目之间的一致性。这可以确保用于模型推理的特征值与请求时的特征状态一致,即使是历史数据也是如此。

Feast 是一个用于管理、存储和服务功能的集中存储库,可确保跨训练和服务环境的一致性和可靠性。

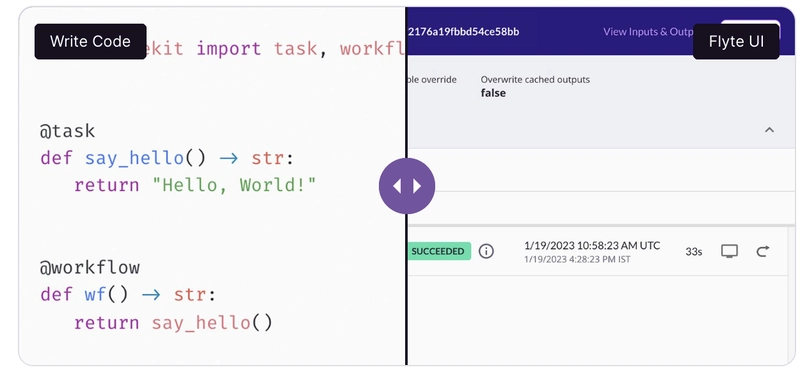

18. 弗莱特

数据科学家和数据与分析管道工程师通常依靠机器学习和平台工程师将模型和训练管道转变为可用于生产的系统。

Flyte赋予数据科学家、数据和分析工程师独立工作的自主权。它为他们提供了用于构建工作流的 Python SDK,并可轻松将其部署到 Flyte 后端。通过构建和执行可靠且可重复的大规模管道,这简化了复杂的机器学习和数据工作流的开发、部署和管理。

19. 特征形式

数据科学家各自为模型开发特征的临时做法,使得其他 AI 项目利益相关者难以理解、重用或基于现有工作进行构建。这会导致重复劳动、特征定义不一致以及结果难以复现。

Featureform是一个虚拟特征库,简化了数据科学家管理和提供机器学习模型特征的能力。它充当 Databricks 和 Snowflake 等现有数据基础架构上的“虚拟”层。这使得数据科学家能够直接为其他利益相关者设计特征并将其部署到数据基础架构中。其结构化、集中化的特征存储库和元数据管理方法使数据科学家能够无缝地将其工作从实验过渡到生产,确保整个机器学习生命周期的可重复性、协作和治理。

20.深度检查

Deepchecks是一款机器学习监控工具,用于持续测试和验证机器学习模型及数据,涵盖 AI 项目从实验到部署的整个过程。它提供多种内置检查,用于验证模型性能、数据完整性和数据分布。这些检查有助于识别模型偏差、数据漂移、概念漂移和数据泄漏等问题。

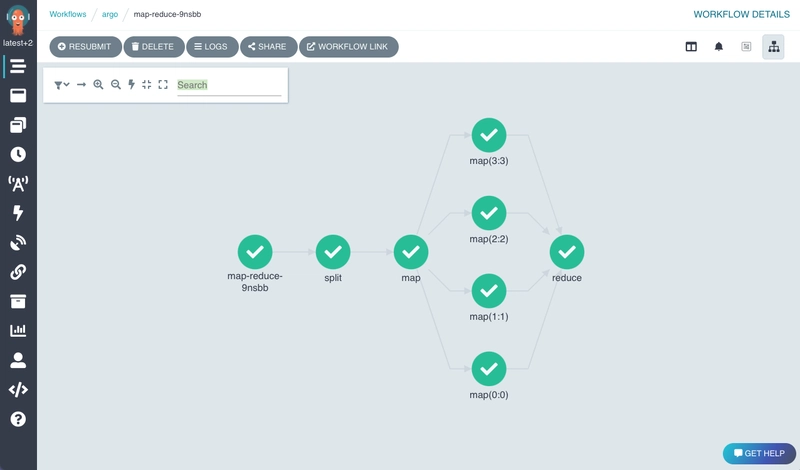

21.《逃离德黑兰》

Argo提供了一个 Kubernetes 原生工作流引擎,用于在 Kubernetes 上编排并行作业。其主要目的是简化复杂、多步骤工作流的执行,使其特别适合机器学习 (ML) 和数据处理任务。它使 ML 工程师能够将 ML 工作流的每个步骤(数据预处理、模型训练、评估、部署)定义为单独的容器,从而更轻松地管理依赖项并确保可重复性。

Argo 工作流使用 DAG 定义,其中每个节点代表工作流中的一个步骤(通常是一个容器化任务),边代表步骤之间的依赖关系。工作流可以定义为一系列任务(步骤),也可以定义为有向无环图 (DAG),以捕获任务之间的依赖关系。

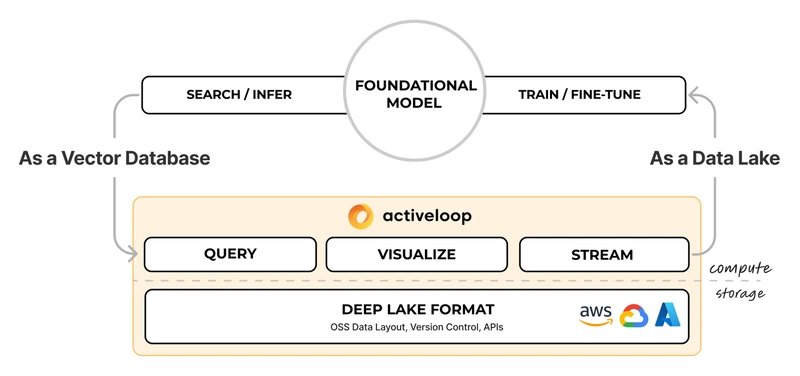

22.深湖

Deep Lake(原名 Activeloop Hub)是一款机器学习专用数据库工具,旨在充当深度学习的数据湖和 RAG 应用的向量存储。其主要目的是通过提供对大规模数据集的快速高效访问(无论其格式或位置如何),加速模型训练。

23. Hopsworks 特色商店

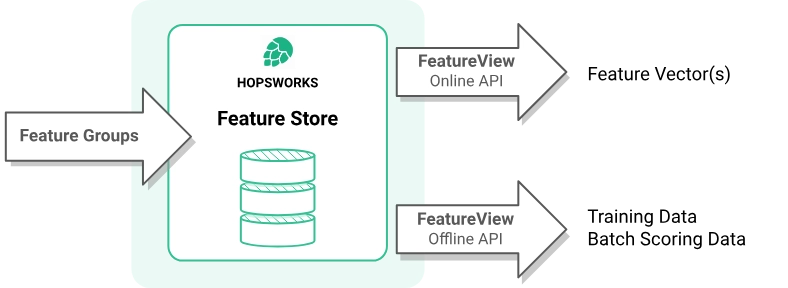

至少达到MLOps 成熟度 1 级架构的高级 MLOps 流水线需要集中式特征存储。Hopsworks是此类架构的理想特征存储。它提供了端到端解决方案,用于管理机器学习特征的生命周期,涵盖从数据提取和特征工程到模型训练、部署和监控的各个环节。这有助于实现特征重用、一致性以及更快的模型开发。

24. NannyML

NannyML是一个 Python 库,专门用于机器学习 (ML) 模型的部署后监控和维护。它使数据科学家能够检测和解决静默模型故障,在没有即时真实数据的情况下评估模型性能,并识别可能导致性能下降的数据漂移。

25. 三角洲湖

Delta Lake是一个为数据湖提供可靠性的存储层框架。它解决了在 Lakehouse 架构中管理大规模数据的挑战,在 Lakehouse 架构中,数据以开放格式存储并用于各种用途,例如机器学习 (ML)。数据工程师可以使用 Delta Lake 构建实时管道或机器学习应用程序,因为它支持批量和流数据处理。它还为数据湖带来了 ACID(原子性、一致性、隔离性和持久性)事务,即使在多个管道并发读写的情况下也能确保数据完整性。

在选择开源 AI/ML 工具时,考虑热门程度、影响力、创新性、社区参与度以及与新兴 AI 趋势的相关性等因素,有助于您做出决策,尤其是在选择提供相同价值主张的工具时。在某些情况下,这些工具可能以不同的方式为同一用例提供解决方案,或者拥有独特的功能,使其非常适合特定的项目用例。

例如,一些模型开发、部署和管理工具(例如 MLRun 或 Kubeflow)提供了平台或 API,方便 AI 项目开发。这通常决定了利益相关者对平台环境、基础架构和工作流程的使用。KitOps 以软件包的形式提供其解决方案,允许 AI 项目中的利益相关者在使用现有工具、环境和开发实践的同时,对其工作进行版本控制和共享。要试用 KitOps 解决方案,请按照本指南开始操作。

文章来源:https://dev.to/kitops/25-open-source-ai-tools-to-cut-your-development-time-in-half-4h5j 后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com