21 个开源 LLM 项目助您成为 10 倍 AI 开发者

人工智能的时间很长,尤其是因为 GPT-4o 和 Claude 等强大的 LLM。

今天,我将介绍 21 个开源 LLM 项目,它们可以帮助您构建一些令人兴奋的东西并将 AI 集成到您的项目中。

作为一名开发人员,我可以自信地说,人工智能并不像其他人所说的那样可怕,那些不学习的人将会落后。

让我们把一切都讲清楚。

顺便说一句,我是 Latitude 的一员,我们正在构建一个开源的 LLM 开发平台。你可以加入ai.latitude.so的候补名单。

你将能够做很多很酷的事情,例如:

⚡ 将提示部署为 api 端点。

⚡ 使用 LLM 进行自动评估。

⚡ 合作进行快速工程。

我非常有信心,它发布后您一定会喜欢它!

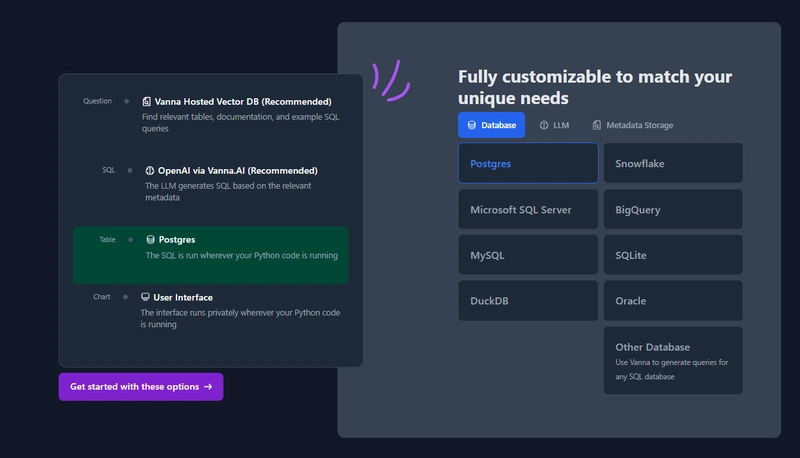

1. Vanna——与您的 SQL 数据库聊天。

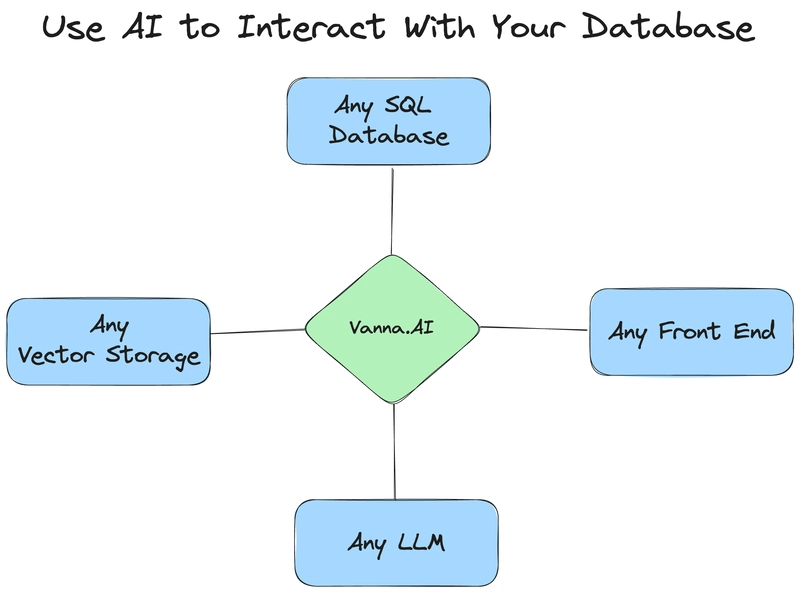

Vanna 是一个 MIT 许可的用于 SQL 生成的开源 Python RAG(检索增强生成)框架。

基本上,它是一个 Python 包,使用检索增强来帮助您使用 LLM 为数据库生成准确的 SQL 查询。

对于像我这样不太喜欢 SQL 查询的开发人员来说,它是完美的!

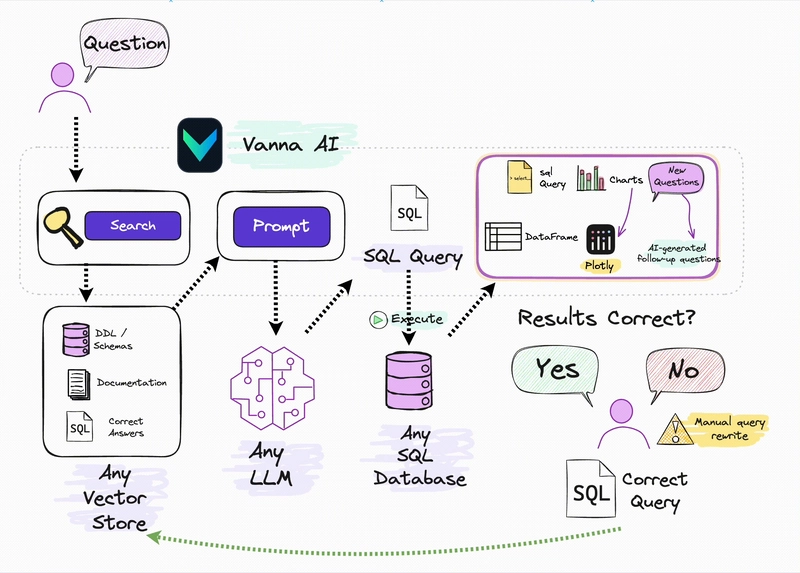

Vanna 的工作分为两个简单的步骤 - 在您的数据上进行训练RAG model,然后提出问题,返回可设置为在您的数据库上自动运行的 SQL 查询。

你不需要知道这整个东西是如何运作的就可以使用它。

你只需要train一个存储一些元数据的模型,然后用它来ask回答问题。

使用以下命令开始。

pip install vanna

为了让事情变得更简单,他们构建了用户界面,您可以将其用作自定义界面的起点。查找所有界面,包括 Jupyter Notebook 和 Flask。

您可以阅读文档,如果您想了解它在训练后是如何工作的,您可以尝试这个Colab 笔记本。

观看此演示以获得完整的演练!

它们在 GitHub 上有 9.5k+ 颗星,并且是使用 Python 构建的。

2. Khoj - 你的人工智能第二大脑。

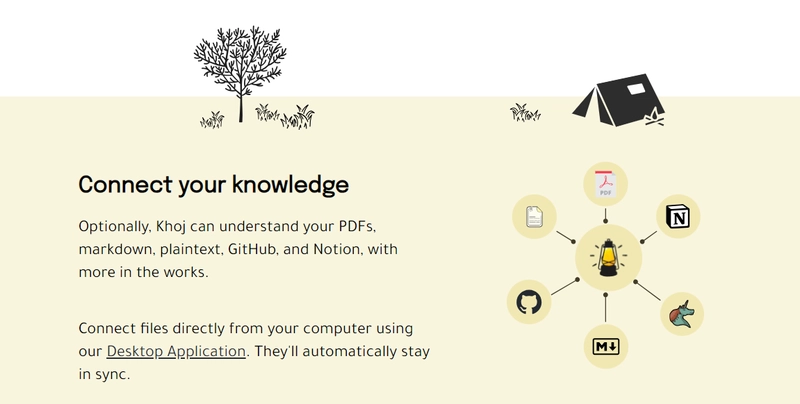

Khoj 是一款开源的 AI 搜索助手。无需翻阅在线搜索结果或您自己的笔记,即可轻松获取答案。

对我来说,这个概念看起来很令人兴奋,它可以帮助我研究很多项目。

Khoj 可以理解您的 Word、PDF、org-mode、markdown、纯文本文件、GitHub 项目甚至 Notion 页面。

它有桌面应用、Emacs 软件包、Obsidian 插件、Web 应用和 Whatsapp AI 等版本。Obsidian 和 Khoj 的组合或许是最强大的!

您可以使用以下命令在几分钟内本地开始使用 Khoj。

$ pip install khoj-assistant

$ khoj

观看实际操作!

一些令人兴奋的功能:

✅ 您可以共享您的笔记和文档来扩展您的数字大脑。

✅ 您的 AI 代理可以访问互联网,从而让您整合实时信息。

✅ 您将在文档上获得快速、准确的语义搜索。

✅ 您的经纪人可以创建深刻的个人形象并理解您的讲话。

例如,说:“根据我的兴趣,画一幅我梦想中的房子的图画”。它就会画出来!

阅读所有功能,包括可共享聊天、在线聊天、文件摘要和各种类别的完整详细信息。

您可以阅读文档,也可以尝试Khoj Cloud进行快速尝试。

在 YouTube 上观看完整的演练!

它在 GitHub 上有 12k 个星,并由 YCombinator 支持。

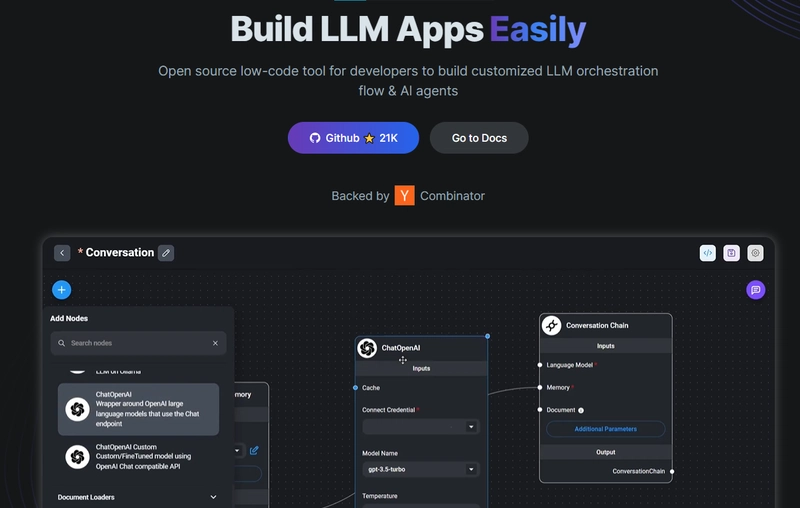

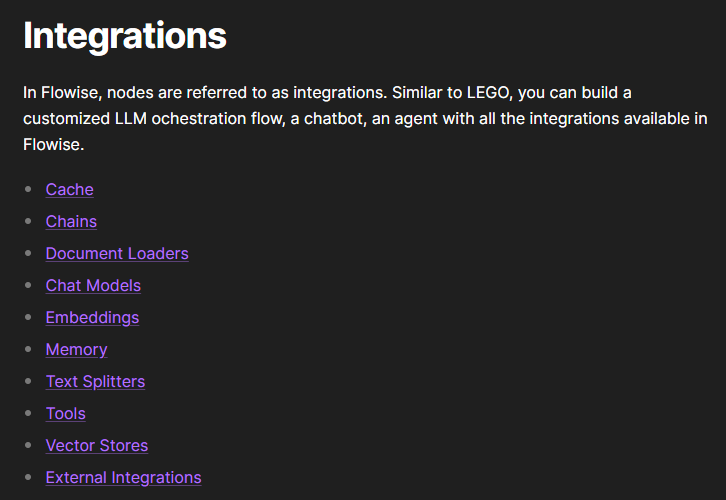

3. Flowise - 拖放 UI 来构建您的自定义 LLM 流程。

Flowise 是一个开源 UI 可视化工具,用于构建您的定制 LLM 编排流程和 AI 代理。

我们不应该比较任何项目,但我可以自信地说,这可能是这里列出的项目中最有用的一个!

使用以下 npm 命令开始。

npm install -g flowise

npx flowise start

OR

npx flowise start --FLOWISE_USERNAME=user --FLOWISE_PASSWORD=1234

这就是您集成 API 的方式。

import requests

url = "/api/v1/prediction/:id"

def query(payload):

response = requests.post(

url,

json = payload

)

return response.json()

output = query({

question: "hello!"

)}

您可以阅读文档。

云主机不可用,因此您必须按照这些说明自行托管。

让我们探讨一些用例:

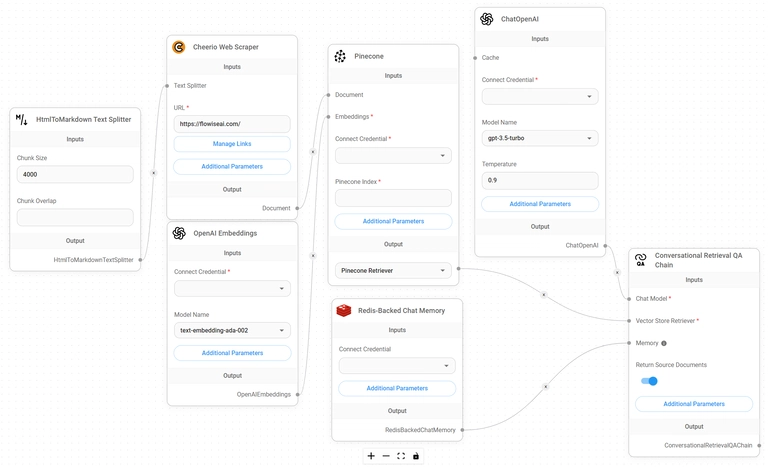

⚡ 假设你有一个网站(可能是商店、电商网站或博客),你想删除该网站的所有相关链接,并让 LLM 解答你网站上的任何问题。你可以按照这个分步教程来操作。

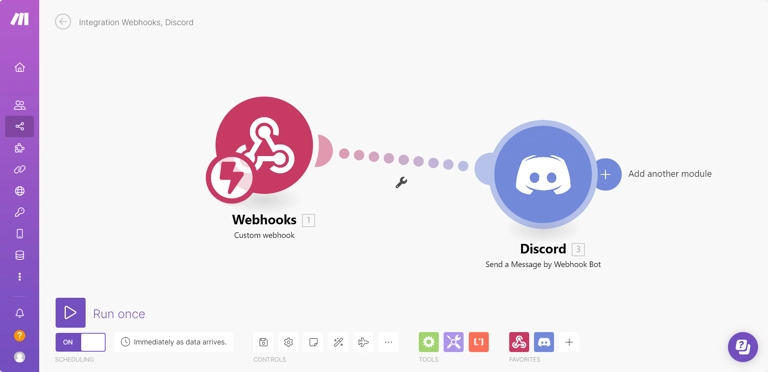

⚡ 您还可以创建一个自定义工具,该工具将能够调用 Webhook 端点并将必要的参数传递到 Webhook 主体中。请遵循本指南,该指南将使用 Make.com 创建 Webhook 工作流。

还有许多其他用例,例如构建 SQL 问答或与 API 交互。探索并构建精彩内容!

FlowiseAI 在 GitHub 上有 27.5k 个星标,并且有超过 14k 个 fork,因此整体比例不错。

4. LLAMA GPT - 一个自托管、离线、类似 ChatGPT 的聊天机器人(由 Llama 2 提供支持)。

LlamaGPT 是一个自托管、离线、类似 ChatGPT 的聊天机器人,由 Llama 2 提供支持。它 100% 私密,您的数据不会离开您的设备。

在最近的版本中,他们还提供了对 Code Llama 模型和 Nvidia GPU 的支持。

您可以从Umbrel App Store安装它,也可以使用 Kubernetes 安装它。

您可以在文档中阅读有关支持的模型。

使用非常简单!

我知道,现在有这么多方法可以在本地运行 LLM 可能会让人感到困惑。作为一名开发者,我认为评估哪种方法适合我们的情况很重要!

他们在 GitHub 上有 10k+ 颗星,并提供 2 个包。

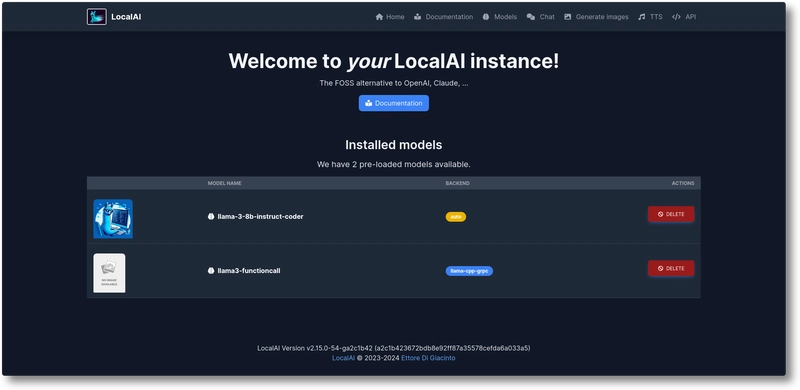

5. LocalAI - 免费的 OpenAI 替代品。

LocalAI 是免费的、开源的,被视为 OpenAI 的替代品。

LocalAI 作为一个直接替代的 REST API,与 OpenAI(Elevenlabs、Anthropic……)API 规范兼容,用于本地 AI 推理。

它允许您在本地或使用消费级硬件本地运行 LLM、生成图像和音频(以及其他功能),并支持多种模型系列。最棒的是,它不需要 GPU。

我从未想过会有这样的选项,所以对于不想花太多钱的开发者来说,这简直是金矿。此外,它还允许生成文本、音频、视频和图像,并且还具有语音克隆功能。你还需要什么呢?

您可以通过 Semaphore CI 观看完整的演练!

有很多集成选项,开发人员已经构建了很棒的东西,例如用于将 LocalAI 实例附加到 VSCode 的扩展。

您可以阅读快速入门指南以及如何使用 kubernetes 运行它。查找所有资源,包括如何在 AWS、k8sgpt 等上运行它。

他们在 GitHub 上有 21k+ 颗星并且即将v2.18发布。

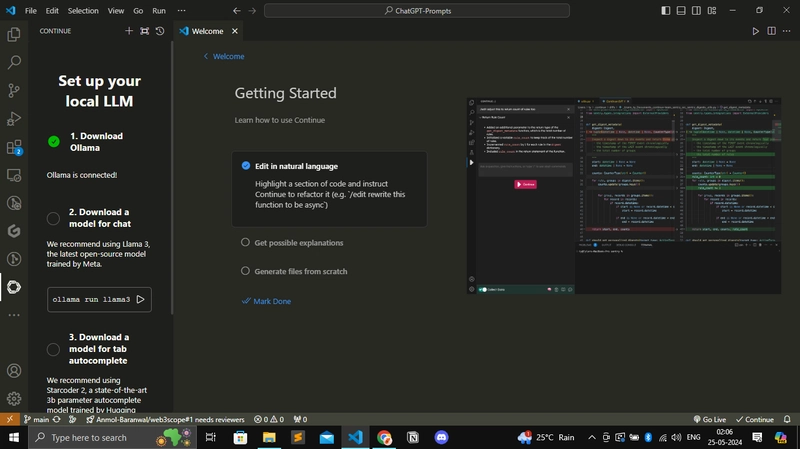

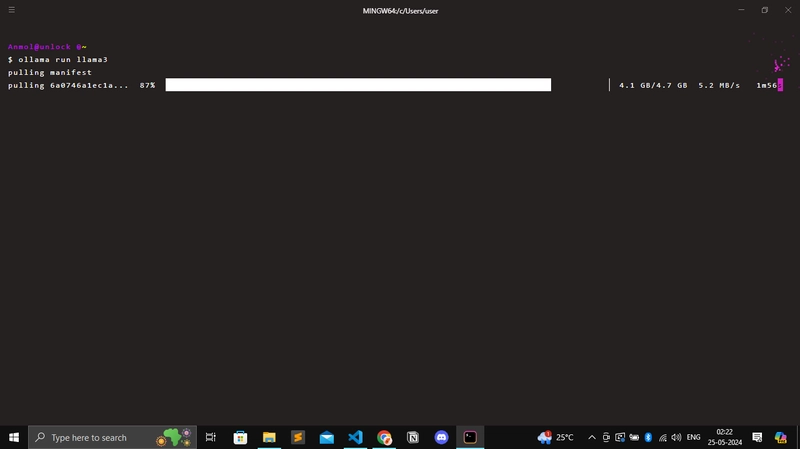

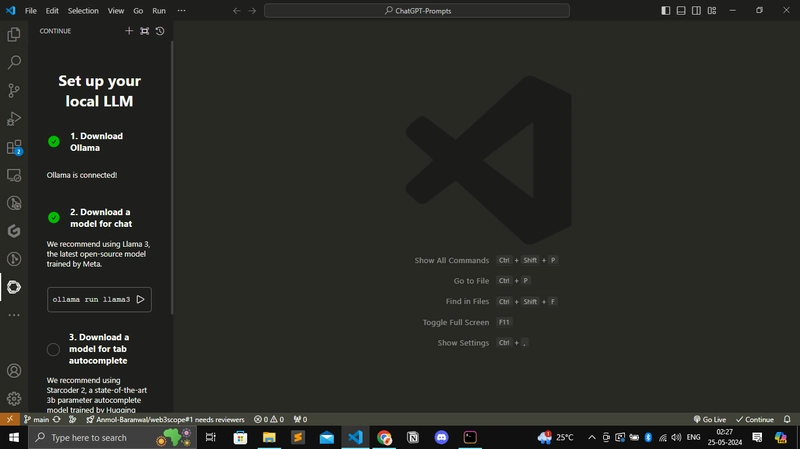

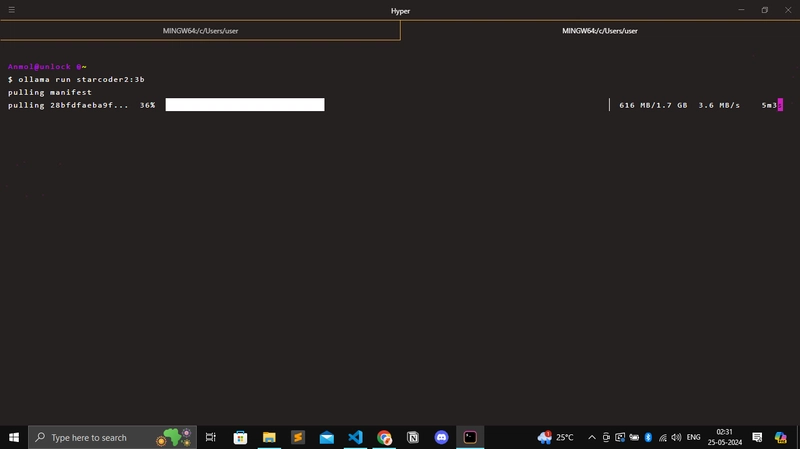

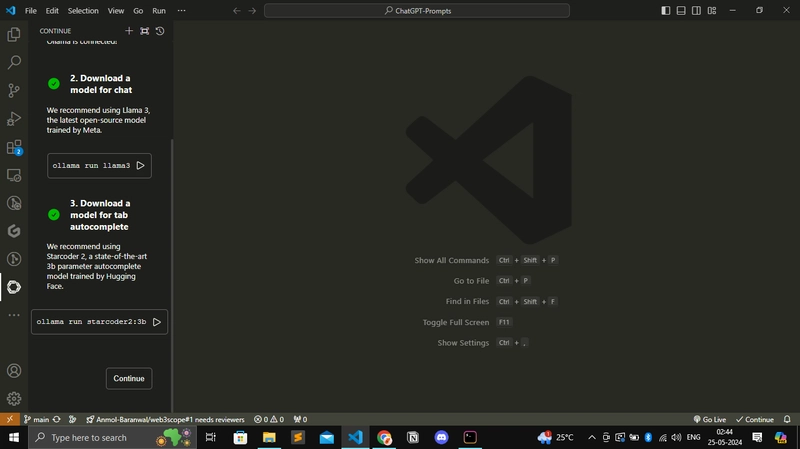

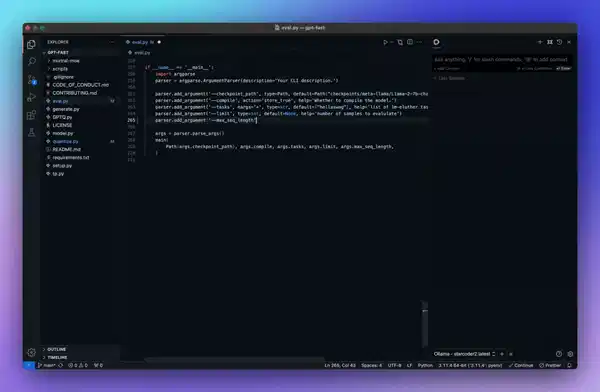

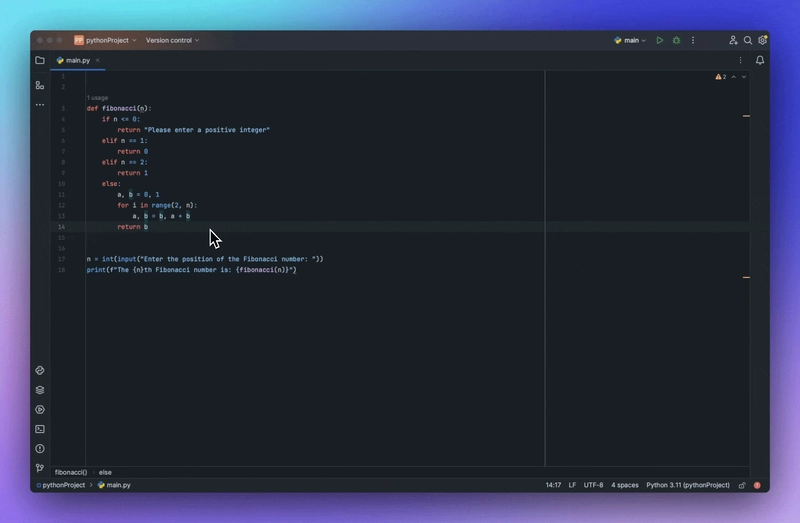

6.继续——使您能够创建AI软件开发系统。

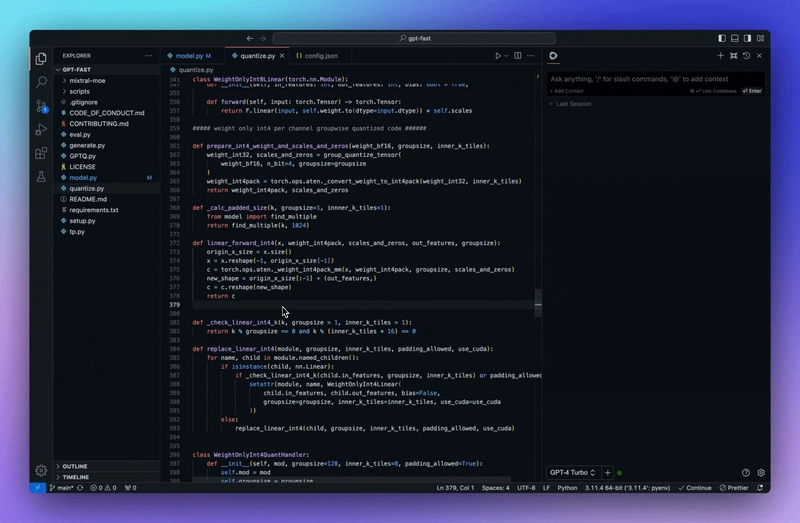

Continue 是我在开发历程中见过的最好的 AI 代码助手之一。

您可以连接任何模型和任何上下文以在VS Code和JetBrains中构建自定义自动完成和聊天体验。

您可以轻松设置。以下是我安装过程中的一些截图。

配置完成后,您就可以使用它提供的所有令人惊叹的概念。

它们有很多很棒的功能,例如:

按 Tab 键自动完成代码建议。

询问有关您的代码库的问题。

立即了解终端错误。

使用斜线命令开始操作。

重构您正在编码的功能。

了解所有功能。

您必须从市场安装VSCode 扩展,然后阅读快速入门指南。

您可以阅读文档。

您还可以在 YouTube 上观看这个基本演示!

它们在 GitHub 上有 13k+ 颗星,并且是使用 TypeScript 构建的。

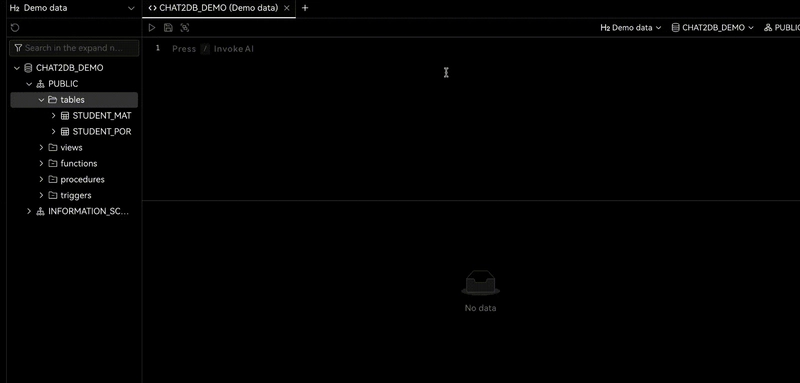

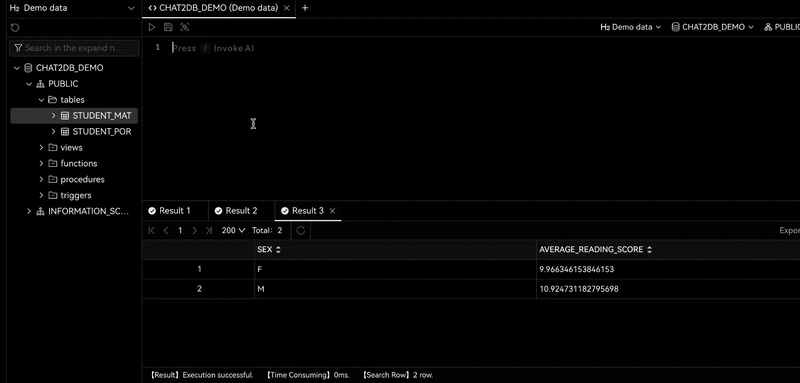

7. Chat2DB——人工智能驱动的数据管理平台。

Chat2DB 是一款 AI 优先的数据管理、开发和分析工具。

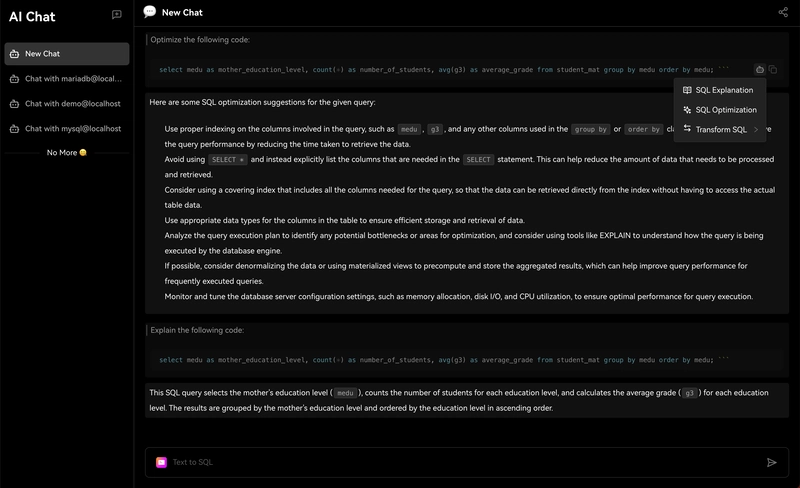

其核心是AIGC(人工智能生成代码),可以把自然语言转换成SQL,SQL转换成自然语言,并自动生成报表,让效率更上一层楼。

即使不懂SQL的操作也可以通过它快速查询业务数据并生成报表。

当你进行任何操作时,它都会给你一些建议。

比如在进行数据库开发时,它会帮你直接用自然语言生成 SQL,给出 SQL 优化建议,帮你分析 SQL 性能,分析 SQL 执行计划,还能帮你快速生成 SQL 测试数据、系统代码等等。其实它很强大 :)

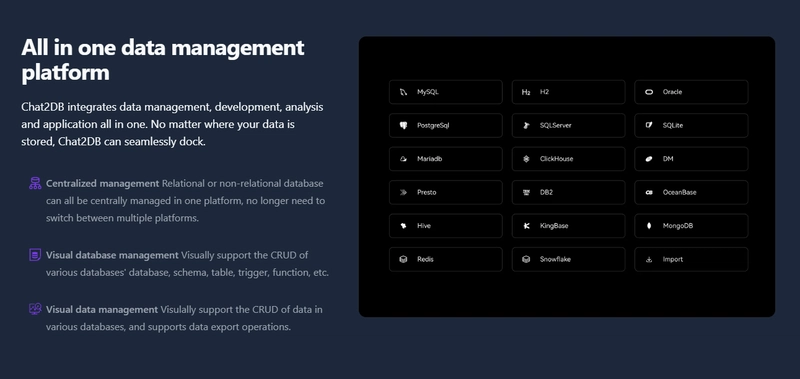

它们对多数据源有出色的支持,并且可以轻松集成多达 17 种不同的数据库类型,包括 PostgreSQL、MySQL、MongoDB 和 Redis。

您可以下载或在浏览器中试用。

让我们看看一些令人兴奋的功能:

✅ 智能报告。

✅ 数据探索。

✅ SQL 开发。

您可以阅读官方文档上的快速入门指南。

他们在 GitHub 上有 14k+ 颗星并且即将发布v3.2。

8. LibreChat——增强型 ChatGPT 克隆。

LibreChat 是一个免费的开源 AI 聊天平台。其 Web UI 提供丰富的自定义功能,支持众多 AI 提供商、服务和集成。

它通过熟悉的界面和创新的附加功能在一个地方为所有 AI 对话提供服务,以满足您所需的尽可能多的用户的需求。

部分功能如下:

✅ 使用 Claude 3、GPT-4、Gemini Vision、Llava 和 Assistants 等高级模型无缝上传和分析图像。

✅ 使用 OpenAI、Azure、Anthropic 和 Google 的各种强大的端点与文件聊天。

✅ 多语言用户界面,支持 20 多种语言。

✅多样化的模型选项,包括 OpenAI、BingAI、Anthropic(Claude)、Azure OpenAI 和 Google 的顶级机器学习产品。

您可以阅读快速入门指南来开始。

观看此视频了解完整演练!

他们在 GitHub 上有 15k+ 颗星,并提供 4 个软件包。

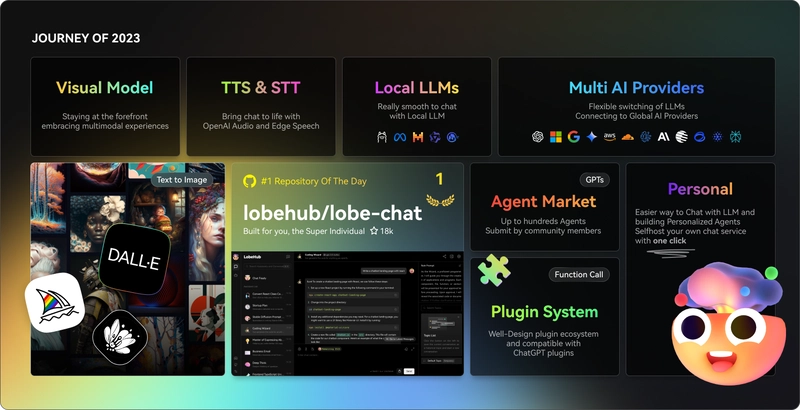

9. Lobe Chat——现代设计的 LLMs/AI 聊天框架。

一个开源的、现代设计的 ChatGPT/LLMs UI/框架。

支持语音合成、多模态和可扩展(函数调用)插件系统。您可以一键部署您的私有 OpenAI。

让我们看看 LobeChat 的一些令人兴奋的功能:

✅ 多模型服务提供商支持。

他们将我们的支持扩展到多个模型服务提供商,而不是仅限于单一的一家。

查找他们支持的10 多个模型服务提供商的完整列表。

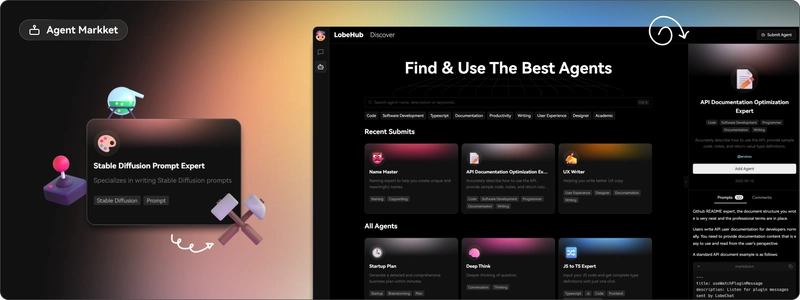

✅ 助理市场。

在LobeChat的助手市场中,创作者可以发现一个汇集了众多精心设计的助手的创新社区。

那里有这么多很棒的应用程序。哇!

✅ 模型视觉识别。

LobeChat现已支持OpenAI的GPT-4-Vision、Google Gemini Pro Vision、智朴GLM-4 Vision等具备视觉识别能力的大型语言模型,使LobeChat具备多模态交互能力。

用户可以轻松地将图像上传或拖放到聊天框中,助手将能够识别图像的内容并进行智能对话。

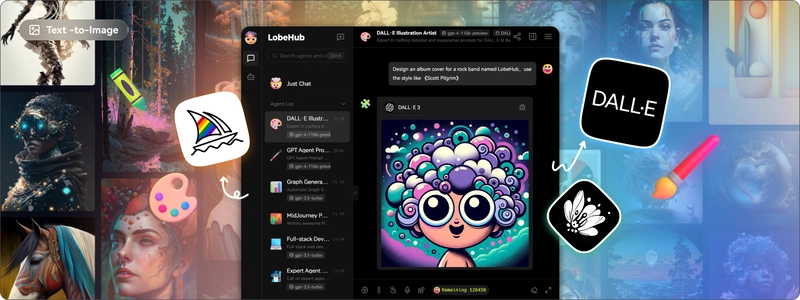

✅ 文本到图像生成。

您可以在与助手对话时直接使用文本转图像工具。

通过利用 DALL-E 3、MidJourney 和 Pollinations 等 AI 工具的强大功能,助手现在可以正确实现它。

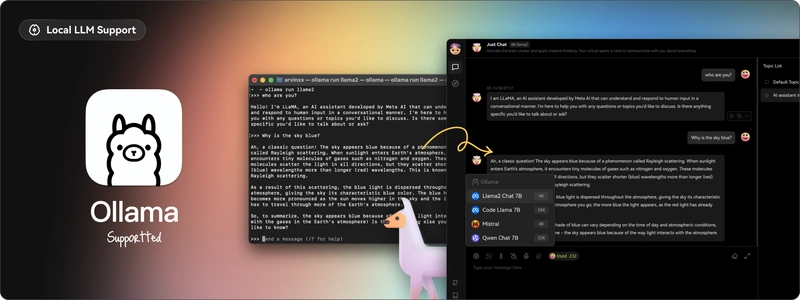

✅ 本地大型语言模型 (LLM) 支持。

借助 Ollama AI 强大的基础设施和社区的协作努力,您现在可以在 LobeChat 中与本地 LLM(大型语言模型)进行对话!

通过运行以下 Docker 命令,您可以在 LobeChat 中体验与本地 LLM 的对话。

docker run -d -p 3210:3210 -e OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 lobehub/lobe-chat

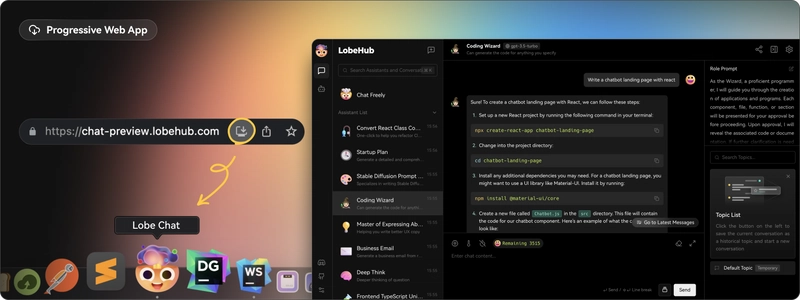

✅ 渐进式 Web 应用程序 (PWA)。

他们采用了渐进式 Web 应用程序 PWA 技术,这是一种将 Web 应用程序提升到近乎原生应用体验的现代 Web 技术。

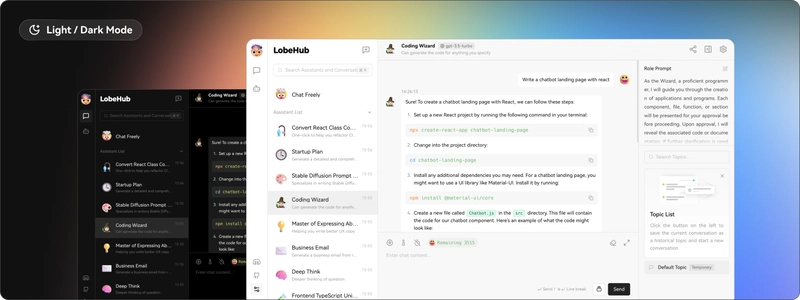

✅ 自定义主题。

了解所有功能和用例。

您可以自行托管或使用 docker 部署它。Lobe Chat生态系统提供了 4个软件包: lobehub/ui、、和lobehub/icons。lobehub/ttslobehub/lint

他们还提供插件市场,您可以在那里找到许多实用的插件,这些插件可用于引入新的函数调用,甚至新的消息结果渲染方式。如果您想开发自己的插件,请参阅📘维基百科中的插件开发指南。

您可以阅读文档。

你可以查看现场演示。非常酷!

他们在 GitHub 上拥有 35k+ 颗星,并且发布了 500 多个版本。

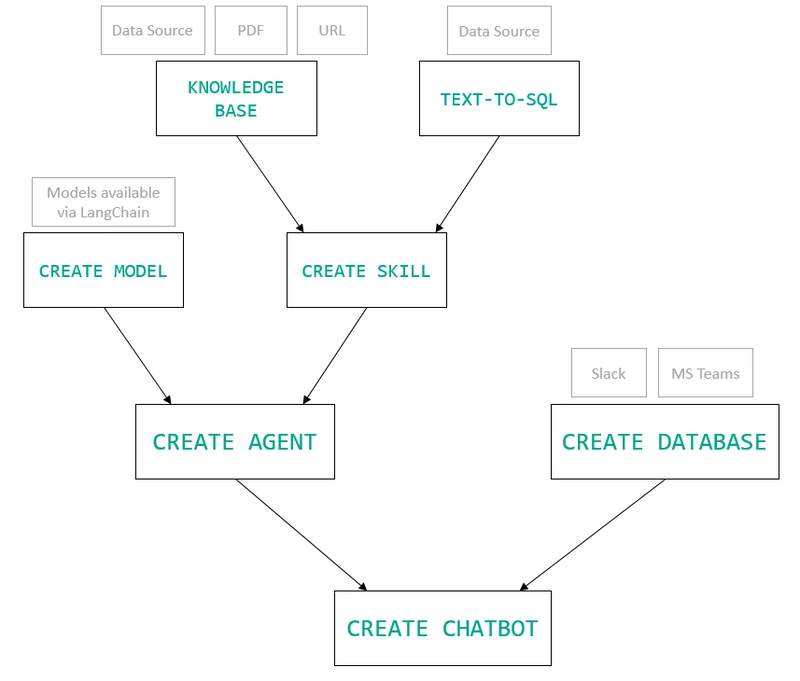

10. MindsDB——从企业数据定制AI的平台。

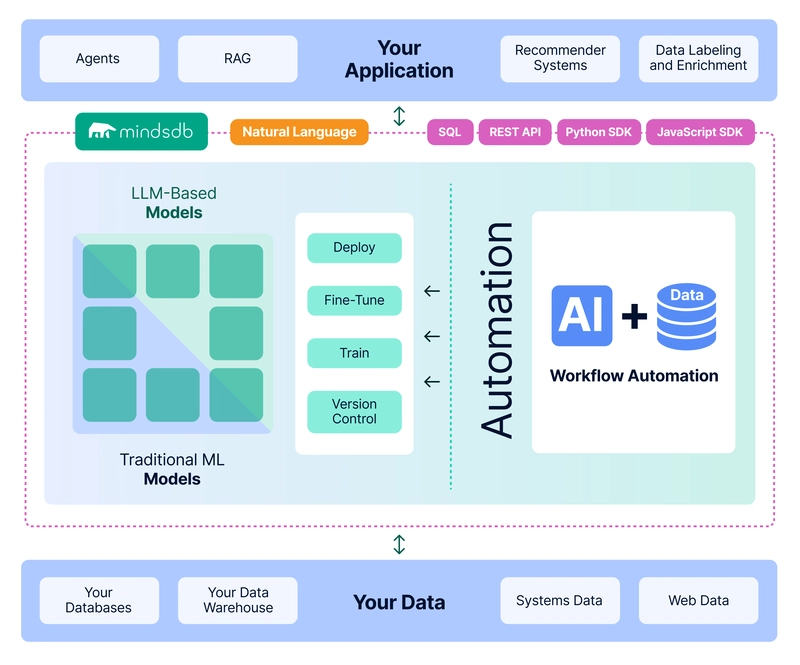

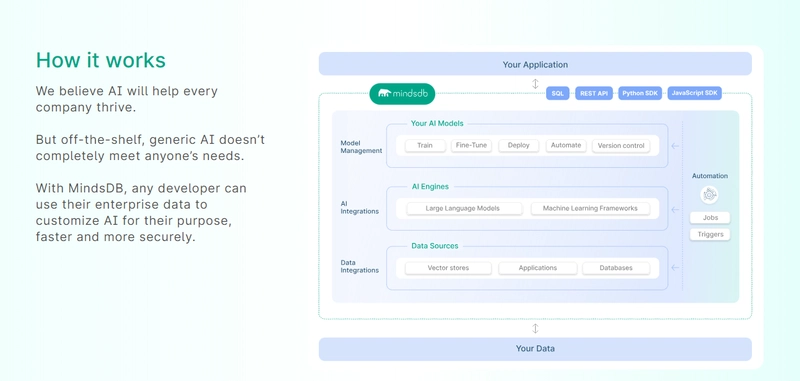

MindsDB 是从企业数据定制 AI 的平台。

使用 MindsDB,您可以实时部署、服务和微调模型,利用来自数据库、矢量存储或应用程序的数据来构建 AI 驱动的应用程序 - 使用开发人员已经知道的通用工具。

借助 MindsDB 及其与数据源和 AI/ML 框架的近200 个集成,任何开发人员都可以使用其企业数据来更快、更安全地定制适合其目的的 AI。

他们目前总共支持3 个 SDK,即使用 Mongo-QL、Python 和 JavaScript。

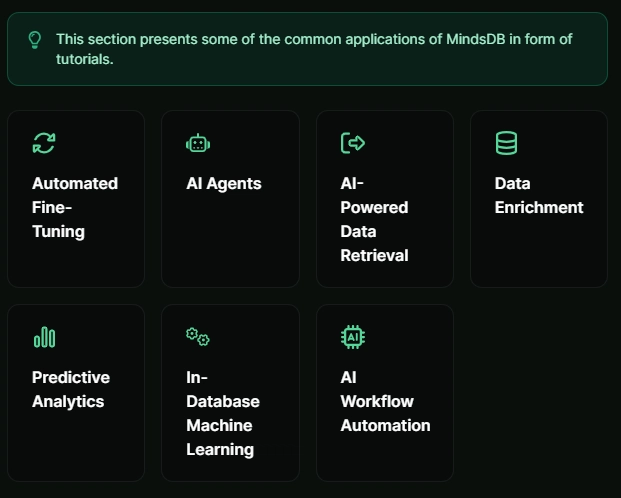

MindsDB 有多种应用,例如与众多数据源和 AI 框架集成,以便您可以轻松地将数据和 AI 结合在一起来创建和自动化自定义工作流程。

其他常见用例包括微调模型、聊天机器人、警报系统、内容生成、自然语言处理、分类、回归和预测。了解更多关于用例的信息,每个用例都配有一个架构图,其中包含一些信息。

例如,使用 MindsDB 的聊天机器人架构图。您可以阅读所有提供的解决方案及其 SQL 查询示例。

// SQL Query Example for Chatbot

CREATE CHATBOT slack_bot USING database='slack',agent='customer_support';

简单介绍一下所有可能性,你可以看看如何利用人工智能 + 物联网传感器数据预测气温。很精彩吧 :)

他们在 GitHub 上拥有超过 25.4k 颗星,并且发布了v24.7.2.0超过 200 个版本。顺便说一句,这是我第一次在任何版本中看到 4 个部分,因为我一直遵循语义发布。

11.AutoGPT——比ChatGPT更令人兴奋。

AutoGPT 的核心是其主要项目,即由大型语言模型 (LLM) 驱动的半自主代理,旨在为您执行任何任务。

AutoGPT 项目由四个主要组件组成:

- 代理 – 也称为“AutoGPT”

- 基准——又名农业基准

- 熔炉

- 前端

了解如何使用 OpenAI 密钥设置 AutoGPT 。

您可以观看Fireship 制作的 YouTube 视频,了解什么是 AutoGPT。

您还可以观看Sentral Media 的AutoGPT 教程。

即使您对 AI 了解不多,您也可以尝试 AutoGPT 来了解如何节省时间并构建很酷的东西。

由于其出色的用例和自动化功能,他们在 GitHub 上拥有 164k+ 颗星。

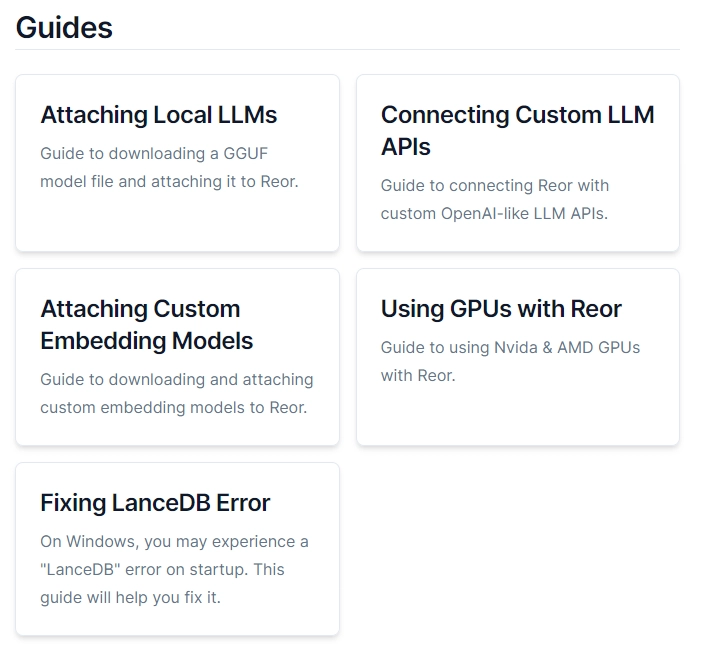

12. reor——自组织 AI 笔记应用程序。

这是迄今为止我见过的最令人兴奋的项目之一,特别是因为它在本地运行模型。

Reor 是一款 AI 驱动的桌面笔记应用。它会自动链接相关笔记,解答笔记中的问题,并提供语义搜索功能。

所有内容都存储在本地,您可以使用类似 Obsidian 的 Markdown 编辑器编辑笔记。该项目假设,用于思维的 AI 工具应该默认在本地运行模型。

Reor 站在巨人的肩膀上Ollama,Transformers.js使LanceDBLLM 和嵌入模型都能在本地运行。此外,它还支持连接到 OpenAI 或与 OpenAI 兼容的 API,例如 Oobabooga。

我知道你一定想知道这怎么可能呢

self-organizing?

a. 你写的每条笔记都会被分块并嵌入到内部向量数据库中。b

. 相关笔记会通过向量相似性自动连接。c

. LLM 支持的问答系统会对笔记语料库进行 RAG 操作。d

. 所有内容都可以进行语义搜索。

您可以在此处观看演示!

可以将 Reor 视为一个包含两个生成器的 RAG 应用:LLM 和人类。在问答模式下,LLM 会从语料库中检索到上下文,以帮助回答查询。

同样,在编辑模式下,我们可以切换侧边栏来显示retrieved语料库中的相关笔记。这是一种非常有效的方法,可以augmenting将当前笔记中的想法与数字收藏中的相关想法进行交叉引用,从而记录你的想法。

您可以阅读文档并从网站下载。支持 Mac、Linux 和 Windows。

他们还提供了入门指南来帮助您入门。

您也可以观看此演练!

它们在 GitHub 上有 6.5k 颗星,并且是使用 TypeScript 构建的。

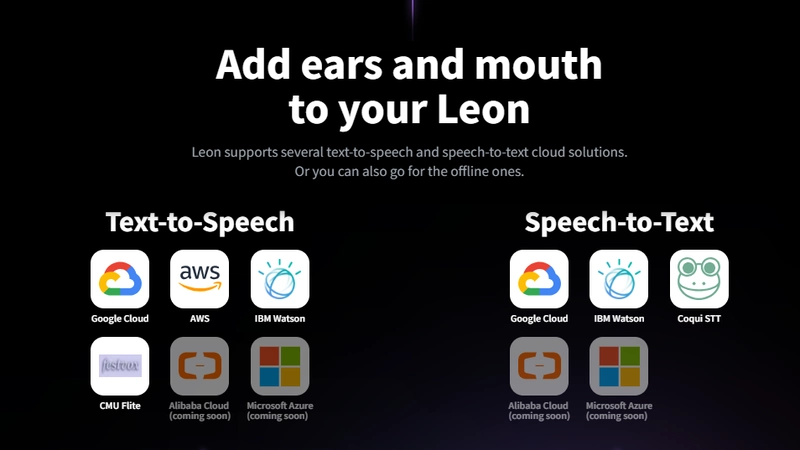

13. Leon——您的开源个人助理。

Leon 是一款开源个人助理,可以驻留在你的服务器上。你肯定很好奇,对吧?😅

你让他做什么他就做什么。你甚至可以跟他说话,他也会回复你。同样,你也可以给他发短信!

无论你是否是开发者,你可能都想构建许多能够帮助你改善日常生活的实用工具。Leon 的Skills架构可以帮助你,无需为每个想法都构建一个专门的项目。

如果您愿意,Leon 可以在离线状态下与您交流,以保护您的隐私。以下是Leon 目前可以使用的技能列表。

你应该读一读Leon背后的故事。你也可以观看这个演示来了解更多关于Leon的信息。

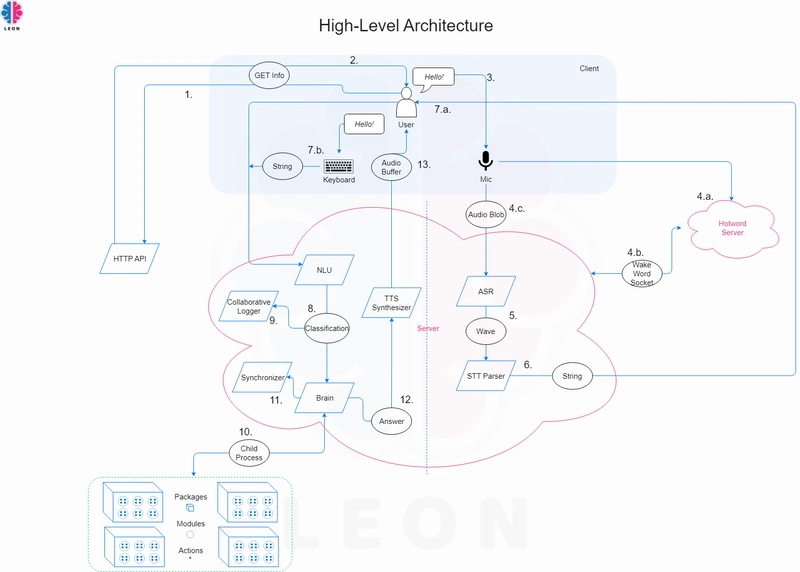

这是 Leon 的高层架构图。

您可以使用此命令安装 Leon。

# install leon global cli

npm install --global @leon-ai/cli

# install leon

leon create birth

您可以阅读文档。

Appwrite 是赞助商之一,这充分说明了它的整体影响力。

它在 GitHub 上有 15k 颗星,并且最近发布了一些重大变化,因此请务必格外仔细地阅读文档。

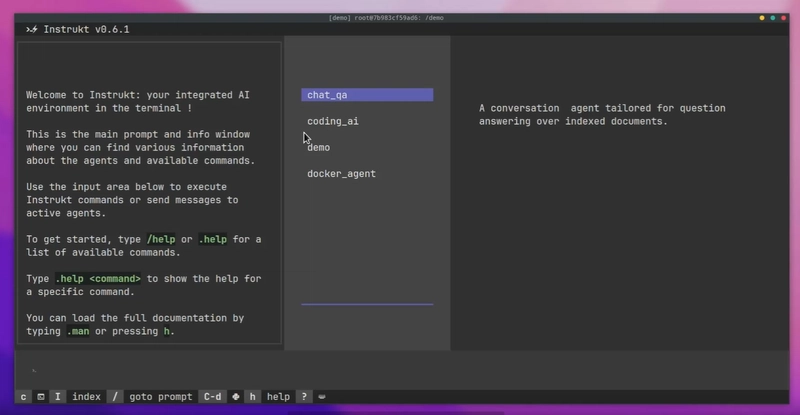

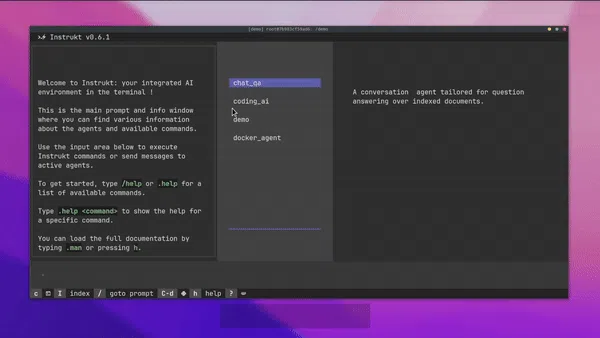

14. Instrukt——终端中的集成AI。

Instrukt 是一个基于终端的 AI 集成环境。它提供了一个平台,用户可以:

- 创建并指导模块化 AI 代理。

- 生成用于问答的文档索引。

- 创建工具并将其附加到任何代理。

用自然语言指导它们,并且为了安全起见,在安全容器(当前使用 Docker 实现)内运行它们,以在专用的沙盒空间中执行任务。

它是使用Langchain、Textual和构建的Chroma。

使用以下命令开始。

pip install instrukt[all]

有很多令人兴奋的功能,例如:

✅ 基于终端的界面,供高级键盘用户无需离开键盘即可指示 AI 代理。

✅ 索引您的数据,并让代理检索数据以进行问答。您可以使用简单的用户界面创建和组织索引。

✅ 索引创建将自动检测编程语言并相应地优化拆分/分块策略。

✅ 在安全的 Docker 容器内运行代理以确保安全性和隐私。

✅ 集成 REPL-Prompt,可与代理快速交互,并为开发和测试提供快速反馈循环。

✅ 您可以使用自定义命令自动执行重复性任务。它还内置了提示/聊天历史记录。

您可以阅读有关所有功能的信息。

您可以阅读安装指南。

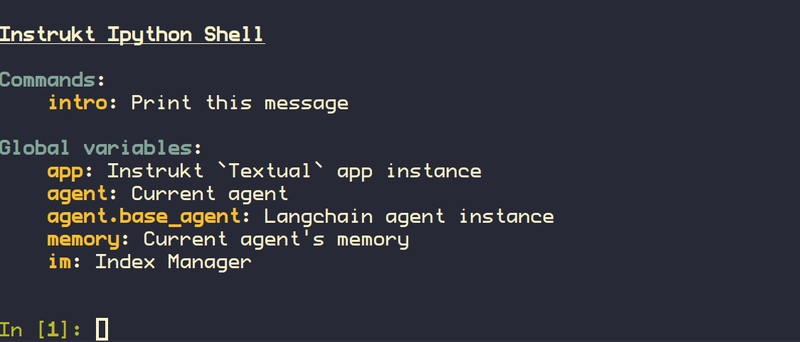

您还可以使用内置的 IPython 控制台来调试和检查代理,这是一个简洁的小功能。

Instrukt 获得 AGPL 许可,这意味着任何人都可以将其用于任何目的。

可以肯定地说,Instrukt 是您的终端的 AI 指挥官。

这是一个新项目,所以他们在 GitHub 上有大约 240 颗星,但用例非常好。

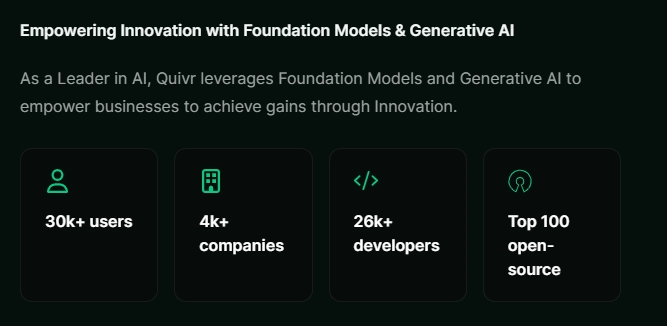

15. Quivr – 用于构建 GenAI 第二大脑的 RAG 框架。

Quivr,你的第二大脑,利用GenerativeAI的力量,成为你的私人助理!你可以把它想象成黑曜石,但配备了AI力量。

Quivr 是一个支持创建 AI 助手(简称 AI 助手)的平台Brain。这些助手拥有专门的功能,例如有些可以连接到特定数据源,让用户直接与数据交互。

而其他一些工具则由 Rag 技术提供支持,作为针对特定用例的专用工具。这些工具处理特定的输入以生成实用的输出,例如摘要、翻译等。

观看 Quivr 的快速演示!

其中一些令人惊叹的功能包括:

✅ 您可以根据想要交互的数据源选择要使用的 Brain 类型。

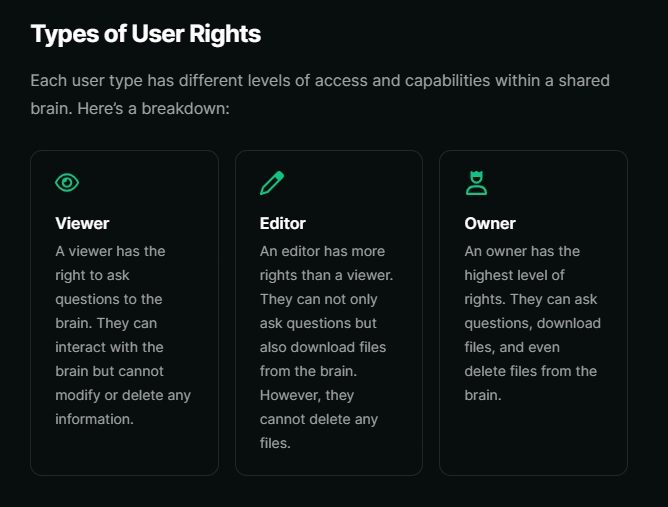

✅ 他们还提供了一个强大的功能,可以与他人分享你的大脑。你可以通过电子邮件与个人共享,并为他们分配特定的权限。

✅ Quivr 可离线工作,因此您可以随时随地访问您的数据。

✅ 您可以访问并继续您过去与大脑的对话。

✅ 但我最喜欢它的一点是,你可以直接安装一个 Slack 机器人。参考这个演示看看它能做什么。太酷了!

无论如何,请阅读有关使用 Quivr 可以做的所有精彩的事情。

您可以阅读文档。

他们还提供了如何使用 Vercel、Porter、AWS 和 Digital Ocean 部署 Quivr 的指南。

他们可以提供更好的免费套餐计划,但这足以让您进行测试。

它在 GitHub 上拥有 30k+ 颗星,并且有 220 多个版本,这意味着它们在不断改进。

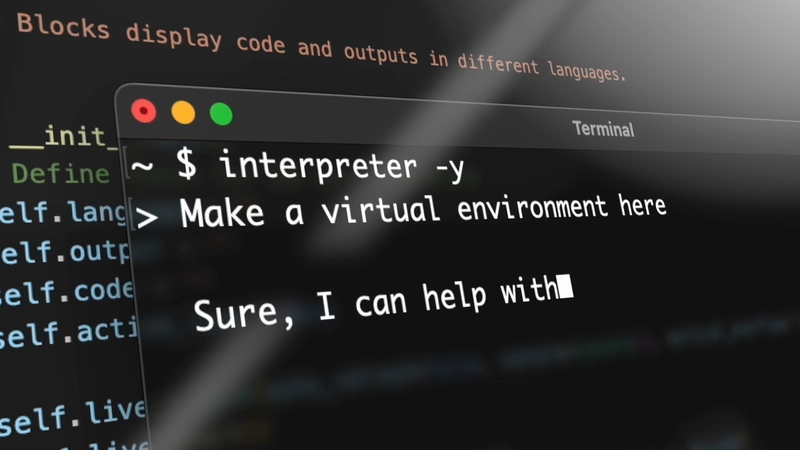

16.开放解释器——终端的自然语言界面。

Open Interpreter 允许 LLM 在本地运行代码(Python、Javascript、Shell 等)。$ interpreter安装后,您可以通过终端中类似 ChatGPT 的界面与 Open Interpreter 聊天。

这为您的计算机的通用功能提供了自然语言界面:

✅ 创建和编辑照片、视频、PDF 等。✅

控制 Chrome 浏览器执行研究绘制、清理和分析大型数据集。

我不知道您怎么想,但是他们的网站让我惊叹不已!

使用此命令快速启动。

pip install open-interpreter

// After installation, simply run:

interpreter

您可以阅读快速入门指南。

您应该阅读有关ChatGPT 代码解释器的比较以及您可以使用的命令。

您可以阅读文档。

Open Interpreter 兼容托管和本地语言模型。托管模型速度更快、功能更强大,但需要付费;而本地模型私密且免费,但功能通常较弱。请根据您的使用场景进行选择!

它们在 GitHub 上拥有 48k+ 颗星,并被 300 多名开发人员使用。

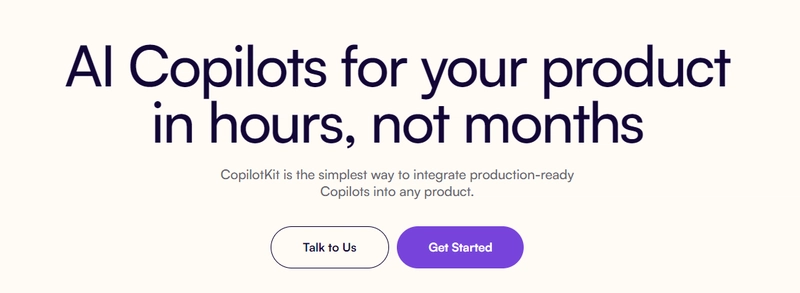

17. CopilotKit – 构建 AI 副驾驶变得容易 10 倍。

您会同意在 React 中添加 AI 功能很困难,而这正是 Copilot 可以作为构建自定义 AI Copilot 的框架来帮助您的地方。

您可以使用 Copilotkit 提供的简单组件构建应用内 AI 聊天机器人和应用内 AI 代理,这比从头开始构建至少容易 10 倍。

如果已经有一个非常简单和快速的解决方案,你就不应该重新发明轮子!

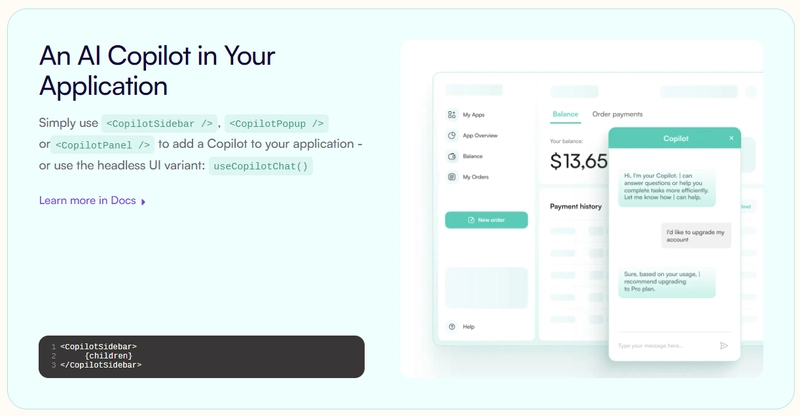

他们还提供内置(完全可定制)的 Copilot 原生 UX 组件<CopilotKit />,如<CopilotPopup />、、、<CopilotSidebar />。<CopilotTextarea />

使用以下 npm 命令开始。

npm i @copilotkit/react-core @copilotkit/react-ui

这就是您集成聊天机器人的方式。

所有与 CopilotKit 交互的组件都必须CopilotKit封装在内。建议您也从这里开始CopilotSidebar(以后可以切换到其他 UI 提供程序)。

"use client";

import { CopilotKit } from "@copilotkit/react-core";

import { CopilotSidebar } from "@copilotkit/react-ui";

import "@copilotkit/react-ui/styles.css";

export default function RootLayout({children}) {

return (

<CopilotKit url="/path_to_copilotkit_endpoint/see_below">

<CopilotSidebar>

{children}

</CopilotSidebar>

</CopilotKit>

);

}

您可以轻松集成 Vercel AI SDK、OpenAI API、Langchain 和其他 LLM 提供程序。您可以按照本指南将聊天机器人集成到您的应用程序中。

其基本思想是快速构建 AI 聊天机器人,且无需费力,尤其是基于 LLM 的应用程序。

您可以观看完整的演练!

CopilotKit 最近在 GitHub 上发布了 300 多个版本,获得了 7000 多颗星。

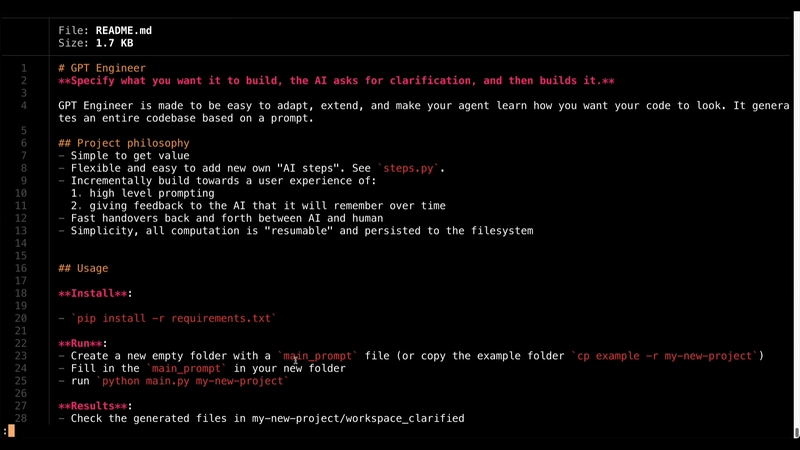

18. GPT 工程师– AI 构建您所要求的内容。

GPT-engineer 让您用自然语言指定软件,坐下来观看 AI 编写和执行代码,并且您可以要求 AI 实施改进。

可以肯定地说,这是一位不需要学位的工程师😅

这是一个用于自动生成 Web 应用的商业项目。它为非技术用户提供了一个 UI,并连接到由 git 控制的代码库。

我知道这让人感到困惑,所以请观看下面的演示来了解如何使用 GPT Engineer。

您可以使用此命令安装稳定版本。

python -m pip install gpt-engineer

默认情况下,GPT-Engineer 需要通过提示文件输入文本。它还可以接受支持视觉模型的图像输入。这有利于为 GPT 工程师添加用户体验 (UX) 或架构图作为附加上下文。了解所有精彩功能。

如果您想要完整的演练,请观看 David 的这个精彩演示!

我建议查看路线图以了解整体愿景。

他们在 GitHub 上拥有 51k+ 颗星并且即将v0.3发布。

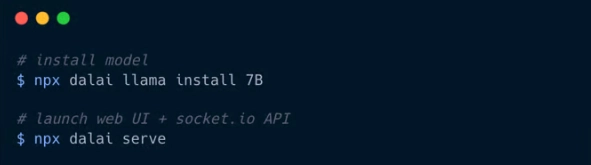

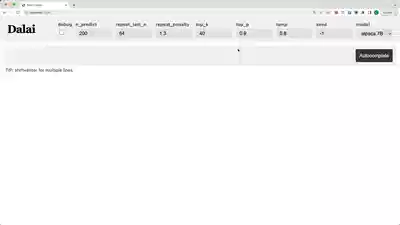

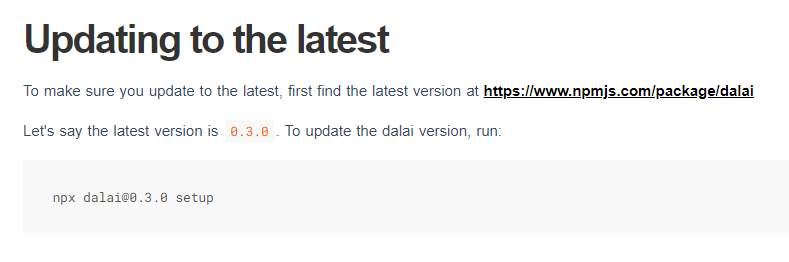

19. Dalai——在本地运行 LLaMA 和 Alpaca 的最简单方法。

Dalai 可让您在计算机上运行 LLaMA 和 Alpaca,由llama.cpp、llama-dl CDN和提供支持alpaca.cpp。

Dalai 可以在 Linux、Mac 和 Windows 等操作系统上运行,所以这是一个加分点!

Dalai 也是一个 NPM 包:

- 以编程方式安装

- 本地向模型发出请求

- 运行 dalai 服务器(由 socket.io 提供支持)

- 以编程方式向远程 dalai 服务器发出请求(通过 socket.io)

您可以使用以下 npm 命令安装该包。

npm install dalai

您可以阅读内存要求以及如何将文件存档到主目录以外的其他地方。

他们在 GitHub 上有 13k 个星,并且仍处于非常早期的阶段。

20. OpenLLM - 在云端以 OpenAI 兼容 API 端点的形式运行 LLM

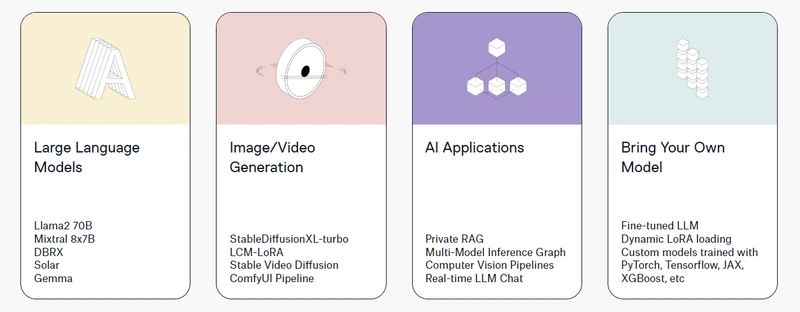

OpenLLM 允许开发人员使用单个命令将任何开源 LLM 作为与 OpenAI 兼容的 API 端点运行。

⚡ 专为快速生产环境构建。⚡

支持 llama3、qwen2、gemma 等,以及众多量化版本(完整列表)。⚡

兼容 OpenAI 的 API,并包含类似 ChatGPT 的 UI。⚡

加速 LLM 解码,配备先进的推理后端。⚡

适用于企业级云部署(Kubernetes、Docker 和 BentoCloud)。

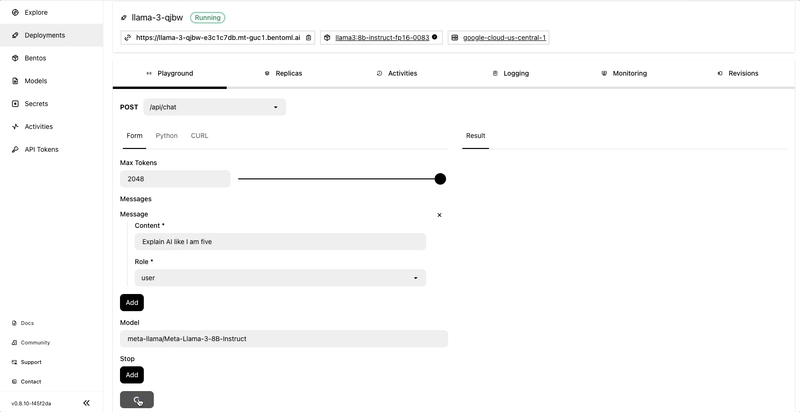

使用以下命令开始。

pip install openllm # or pip3 install openllm

openllm hello

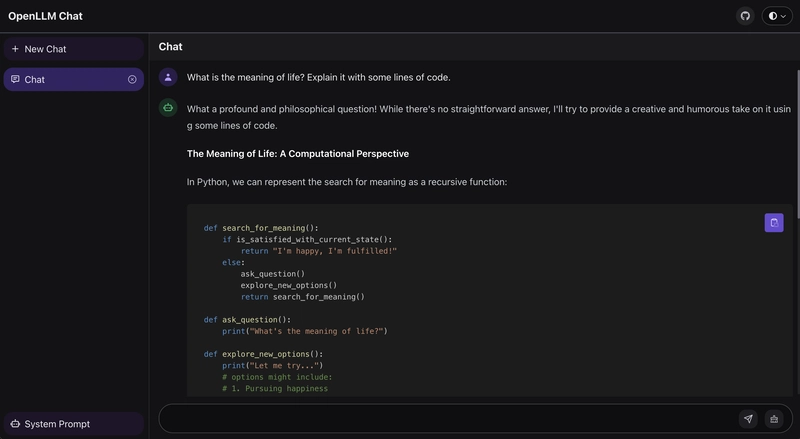

OpenLLM 在 /chat 端点为 LLM 服务器提供了一个聊天用户界面 (UI)。您可以访问该聊天用户界面,http://localhost:3000/chat并与模型发起不同的对话。

OpenLLM 通过统一模型服务框架 BentoML 和面向企业 AI 团队的 AI 推理平台 BentoCloud 支持 LLM 云部署。

如果您不知道,BentoCloud 提供了一个完全托管的基础架构,该基础架构针对 LLM 推理进行了优化,具有自动扩展、模型编排、可观察性等功能,可让您在云中运行任何 AI 模型。

您可以阅读有关支持的模型以及如何启动 LLM 服务器的信息。

openllm run探索文档,您还可以使用并指定模型版本 -在 CLI 中与模型聊天openllm run llama3:8b。

对于像我这样喜欢探索演练的人,请观看 Matthew 的这个演示!

他们在 GitHub 上有 9k+ 颗星,并且有 100 多个版本,因此它正在快速增长。

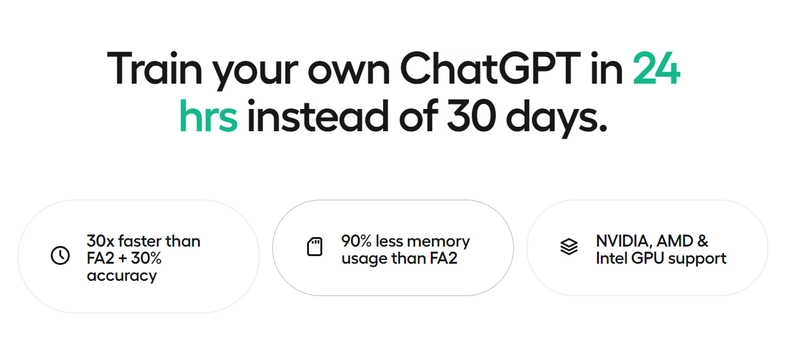

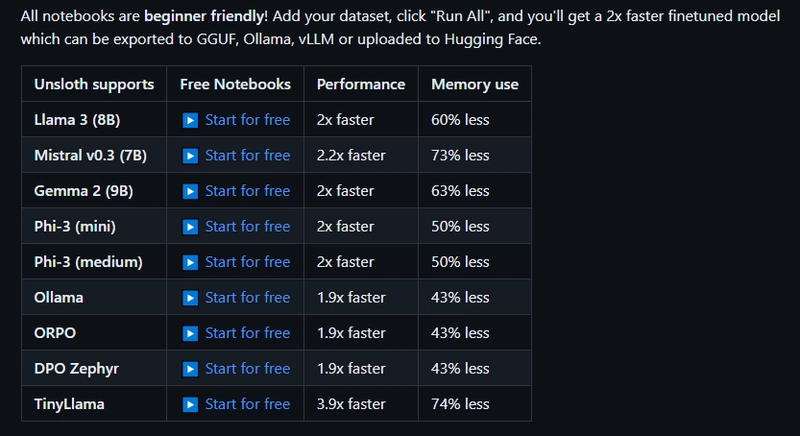

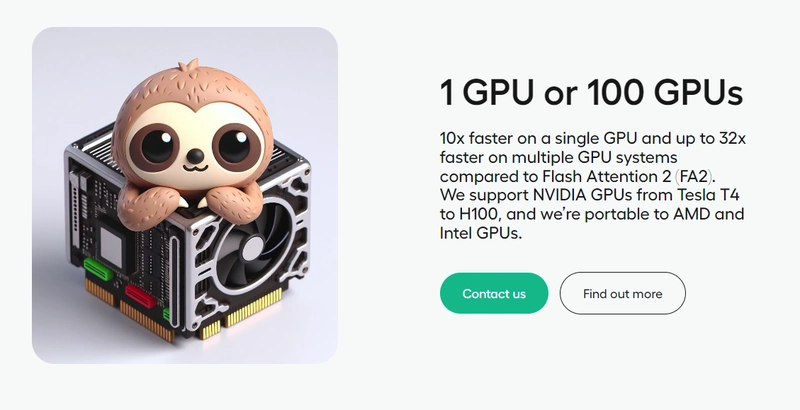

21. Unsloth ——Finetune Llama 3、Mistral、Phi 和 Gemma LLM 速度提高 2-5 倍,内存占用减少 80%。

Unsloth 使 Llama-3、Mistral、Phi-3 和 Gemma 等大型语言模型的微调速度提高 2 倍,内存使用量减少 70%,并且准确率不会降低!

✅ 什么是微调?

如果我们希望语言模型学习一项新技能、一门新语言、一些新的编程语言,或者只是希望语言模型学习如何遵循和回答指令(例如 ChatGPT 如何运作),我们就会进行微调!

brains微调是通过反向传播来更新语言模型实际值的过程。但是,微调可能会非常缓慢,并且非常耗费资源。

Unsloth 可以本地安装,也可以通过其他 GPU 服务(例如 Google Colab)安装。大多数人通过 Google Colab 接口使用 Unsloth,该接口提供免费的 GPU进行训练。

一些突出的事情:

✅ 开源训练速度提高 5 倍,专业版声称速度提高 30 倍。

✅ 未使用任何近似方法,导致准确度损失 0%。

✅ 无需更换硬件,通过 WSL 在 Linux 和 Windows 上运行。

您可以直接在 Hugging Face 上阅读文档和所有上传的模型。

他们还提供了有关如何微调 Llama-3 并导出到 Ollama 的详细指南。

他们在 GitHub 上有 12.5k+ 颗星,这是一个有效的解决方案。

我希望你学到了一些新东西!

我相信学习使用这些强大的 LLM 是一种选择,并且您(作为开发人员)可以根据自己的用例找到更好的生产力解决方案。

祝您拥有美好的一天!下次再见。

关注 Latitude 以获取更多类似内容。

文章来源:https://dev.to/latitude/21-open-source-llm-projects-to-become-10x-ai-developer-fe0 后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com