检索增强生成 (RAG):如何让 AI 模型学习你的数据并给出答案 漩涡 AWS 安全上线! 随着人工智能和大型语言模型的不断发展,人们对从数据源获取答案的需求也越来越高。促使人们整合各种方法从不同来源搜索和检索数据,并将其传递给这些人工智能模型变得至关重要。 检索增强生成(RAG)是一个潜在的解决方案。

如果您渴望了解 RAG 如何改变您访问和使用数据的方式,请继续阅读。

人工智能和生成类似人类的反应。🙋♂️ 回溯到 2013 年,人工智能的格局截然不同。当时人们热议的是简单的神经网络,它是未来发展的基础模块。如果能够快速训练并在 MNIST 数据集上取得好成绩,人们就会感到欣喜。

后来,我们得到了能够执行图像和语音识别等领域任务的深度神经网络,其表现优于传统算法。

但真正的转折发生在2022年11月。OpenAI推出了ChatGPT。它席卷了全球。短短两个月内就积累了超过1亿用户,这是互联网和人工智能历史上最重要的时刻。

不仅因为它能够执行多项任务,更因为它的能力让很多人惊叹不已。此后,大型语言模型风靡全球。我们看到越来越多的人工智能初创公司和企业正在开发自己的大型语言模型。

现在问题来了:任何人都可以使用自己的数据,将其传递给法学硕士 (LLM),并利用这些数据即时生成见解吗?

但在此之前,让我们先讨论一下 AI 大型语言模型当前面临的挑战。

AI 大型语言模型的局限性 虽然大型语言模型确实做得很好,但依赖它们却更具挑战性。请考虑以下 标题 :

ChatGPT 确实抢走了这个人的工作。

如果你是法学硕士(LLM)的常客,或者尝试过测试它们的极限,你一定注意到了一个严重的问题:幻觉。任何大型语言模型都会开始根据其创造力生成答案和其他东西,无论这种创造力是否存在。在上面的例子中,ChatGPT 提供了一些根本不存在的参考案例。

这使得企业、医院和其他机构无法立即将 AI 模型引入日常工作。然而,幻觉并非最先进的大型语言模型面临的唯一问题。还有更多问题。以下是其中一些问题的列表 👇

上下文窗口 :设置一个训练截止时间,超过该时间训练就会停止。因此,它限制了 AI 模型在该日期之后无法生成任何内容。 训练数据过时 :数据是动态的,事实是静态的。因此,为了跟上不断变化的趋势,我们需要重新训练AI模型,这带来了第三个问题。 成本 :AI 模型并非存储在硬盘上。它们会占用 RAM、CPU 和 GPU 来运行和训练。这些成本高昂;重新训练大型语言模型的硬件成本可能会迅速飙升。 准确性与偏差 :由于训练数据存在偏差、缺乏常识推理以及模型的训练方式,LLM 容易出错。这也取决于工程师团队。 LLM 黑客攻击和劫持 :最近的研究开始表明,LLM 可能被黑客攻击并泄露潜在的危险信息。

动图

与其他软件一样,这些 AI 模型并非 100% 完美,并且会不断改进。现在,让我们了解 RAG 是什么以及它为何如此重要。

检索增强生成(RAG)✨ 检索增强生成 (RAG) 是人工智能领域的一项最新进展。它是一种利用检索器和生成式 AI 模型的开放域问答系统。它将搜索系统与 ChatGPT、Llama2 等 AI 模型相结合。借助 RAG,系统可以在庞大的知识库中搜索最新的数据和文章。然后,AI 会利用这些数据给出精准的答案。这种方法有助于减少 AI 响应中的错误,并提供更具个性化的解决方案。

因此,借助 RAG,检索者或搜索者可以从庞大的知识库中访问最新的数据、来源和其他重要文章。然后,它将这些信息作为输入提供给生成式 AI 模型。因此,它被称为“检索器增强生成”。这种方法使大型语言模型能够利用庞大的知识库,并提供相关且切中要点的信息。

这显著改善了大型语言模型所面临的幻听问题,并能为您提供量身定制的答案。

为什么要使用检索增强生成?现有的AI模型还不够吗? 当前一代的 AI 模型都有一个截止期,过了这个截止期之后,它们就会停止训练。因此,我请求获取此后发生的事件。尝试检索最近的信息可能颇具挑战性。

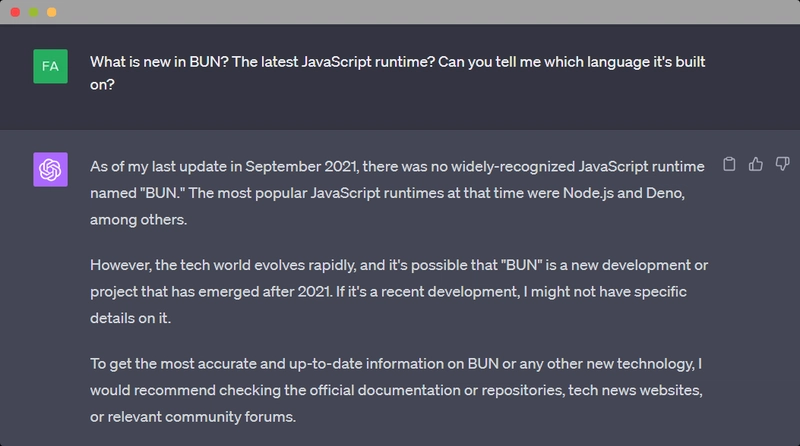

看看这个例子。向 ChatGPT 询问 BUN 的情况

ChatGPT 推荐:

我建议查看官方文档或存储库、科技新闻网站或相关社区论坛。

我们能不能把这些文档、存储库、网站和社区论坛的文本直接发送到 ChatGPT 中,并获得相关答案呢?RAG 可以帮上忙。

不仅仅是关于 BUN。但是,如果你想以同样的方式查询公司的数据,并在不公开的情况下获得与你自己的数据相关的见解和答案,那该怎么办呢?

这正是检索增强生成 (Retrieval Augmented Generation) 的闪光点,它能提供有数据源的答案。而且,在连接多个数据源的问题上,Swirl 可以帮助您快速解决问题。

连接到各种数据源。 Swirl 可以通过 ChatGPT 执行查询处理。 通过 spaCy 的大型语言模型重新排序并获取前 N 个答案。(余弦相关性处理器)

我们深知,对于企业客户而言,时间至关重要。Metapipe (企业版)能够帮助企业客户快速设置 RAG 管道,从而快速获得解决方案。如果您想了解更多关于 Metapipe(企业版)如何助力贵公司的信息,欢迎随时 联系 Swirl 团队。

RAG 与微调 什么是微调? 微调大型语言模型是指在数据集上重新训练任何大型语言模型,使其能够很好地胜任某个子任务。人们已经对 LLaMa2 LLM 进行了微调,使其能够胜任各种任务,例如编写 SQL 语句、Python 代码等。 (参考)

虽然这对于处理海量静态数据(例如 Python 语法、SQL 等)的任务来说很有效,但当你想用新数据或没有可用的大型数据集来训练它时,问题就来了。 如果数据集不断变化,你就必须重新训练模型以适应变化。而这成本很高。

考虑将其编码到 BUN、Astro、Swirl 或贵公司的文档中。另外,请注意,微调可以使它更适合特定任务。您可能无法访问该来源或获取该来源的相关引用。

你能做微调吗? 回答以下问题:

您是否拥有训练大型语言模型所需的工程师和硬件? 您是否拥有从大型语言模型中获取良好答案所需的数据? 你有时间吗?

如果这三个问题中的任何一个答案是“否”,那么你需要重新考虑微调,并选择更好、更便捷的替代方案。

RAG 适合精细调整不适合的情况。

小文档。 文章、研究论文、博客。 新创建的代码库等

从中生成答案比您想象的要容易。虽然有很多选项可以用来创建 RAG 管道,但 Swirl 让检索和生成这两个部分都变得更容易。Swirl 可以根据搜索查询和软件模型进行搜索并提供前 N 个最佳答案。查看我们的 GitHub 。

但是,如果您是企业客户,Swirl 的 Metapipe 可以提供一种更快捷的生成答案的方式。后者面向企业客户,而前者仍然是开源的。

为 Swirl 做出贡献🌌 Swirl 是一个 Python 开源库 🐍。我们正在寻找能够帮助我们构建该软件的人才。我们正在寻找具备以下能力的优秀人才:

创建优秀的文章,增强我们的自述文件、UI 等。 通过添加连接器或搜索提供程序做出贡献。 加入我们的Slack 社区 。

如果您能在 GitHub 上给我们点个🌟 ,那将意义非凡 。这能激励团队 。🔥

无需移动数据,即可进行 AI 搜索和 RAG 操作。从公司 100 多个应用的知识库中获取即时答案,同时确保数据安全。部署只需几分钟,无需数月。

漩涡

无需将数据移动到云端,即可为您的团队提供 ChatGPT 级搜索

60 秒内将 RAG 与 One Drive 和 Microsoft 365 结合使用 提出问题 → 获取答案和来源 → 点击查看来源

在YouTube 上观看

使用 SWIRL 的团队每周平均可节省 7.5 小时的生产时间。

🤔 为什么选择 SWIRL?

避开复杂性,保持强大功能

❌ 无 SWIRL

设置矢量数据库 移动数据 复杂的 ETL 管道 数周的基础设施工作 安全难题

✅ 使用 SWIRL

一个docker命令 数据保留在原处 无需向量数据库 2分钟设置 企业级安全

🚀 与众不同

无向量 DB 戏剧

# No need for:# Just this:

Enter fullscreen mode

Exit fullscreen mode

💡 您可以用 SWIRL 构建什么? 团队的真实例子……

链接检索 https://dev.to/swirl/retrieval-augmented-generation-rag-how-to-get-ai-models-learn-your-data-give-you-answers-1hk9  后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com