网页抓取——完整指南

介绍

Web Scraping,也称为数据提取或数据抓取,是从网站或其他来源以文本、图像、视频、链接等形式提取或收集数据的过程。

当某个网站没有官方 API 或数据访问受到限制时,Web Scraping 会很有帮助。它有多种用途,例如价格监控、媒体监控、情感分析等。

它有助于企业根据互联网上大量可用的公共数据做出决策,这些数据可以借助数据抓取轻松提取。

如今,数据已成为市场上的新型“石油”。如果运用得当,企业能够领先于竞争对手,从而实现目标。这样,他们就能充分利用这一优势。“你拥有的相关数据越多,你做出的决策就越明智。”

在这个博客中,我们将了解有关网络抓取的所有知识,包括它的方法和用途、正确的操作方法以及与之相关的各种其他信息。

什么是网页抓取?

Web Scraping 是借助网站服务器上的 HTTP 请求从单个或多个网站提取数据的过程,以访问特定网页的原始 HTML,然后将其转换为所需的格式。

我们有时会从网页复制内容,并将其嵌入到 Excel 文件或其他文件中。这其实就是网页抓取,只不过规模较小。对于大规模抓取,开发人员会使用网页抓取 API,它可以快速收集大量数据。

使用网络抓取 API 的好处是您不必定期从网站复制数据,但您可以使用可自动执行该过程的 API,从而节省您宝贵的时间和精力。

网页抓取的用途

网页抓取是一种强大且实用的工具,可用于多种用途:

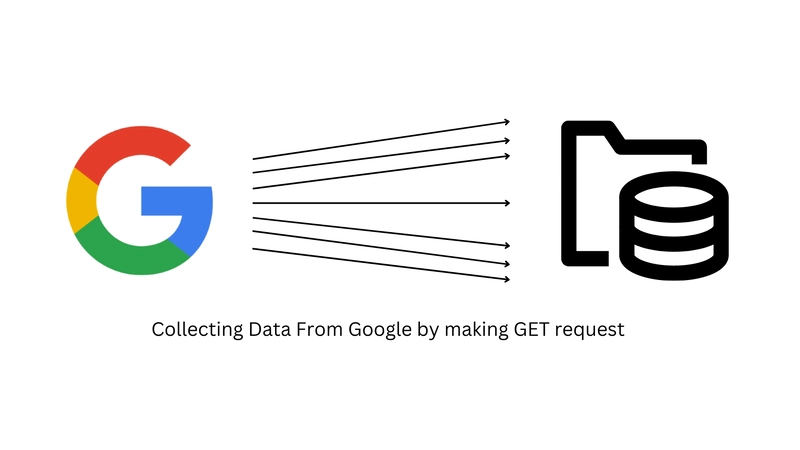

搜索引擎优化

网络抓取可用于从谷歌等搜索引擎提取大量数据,然后利用这些抓取的信息来追踪关键词、网站排名等等。这对您的业务大有裨益,因为借助数据驱动的研究,您可以提高产品在市场上的知名度。

您可以使用市面上各种专用的Google 搜索 API来抓取 Google 搜索结果。它们会从 Google 网页上抓取每一点信息,并将原始 HTML 代码转换为 JSON 格式,并以结构化格式提供结果。

阅读更多:如何抓取谷歌搜索结果

数据挖掘

借助网络抓取,人们可以收集有关其竞争对手和产品的大量数据,了解他们的战略,并根据市场上可用的数据做出明智的决策。

价格监控

这是网络数据抓取最流行的用途之一。价格监控可以用来收集市场上竞争对手或多家在线零售商的定价数据,帮助消费者找到市场上最划算的商品,从而省钱。

新闻与媒体监测

网络抓取可用于追踪全球发生的时事新闻和事件。借助网络抓取,您可以访问《纽约时报》、《华盛顿邮报》、《经济时报》等大型新闻机构的大量文章。

如果您经营一家公司,并且该公司不时出现在新闻中,并且您想知道谁在谈论您的公司或品牌,那么抓取新闻数据对您来说可能是一件有益的事情。

潜在客户开发

网络抓取可以帮助您的公司从各种在线资源中挖掘潜在客户。您可以定位特定人群,而无需发送大量电子邮件,这对您的产品销售大有裨益。

因此,网页抓取的用途多种多样,具体取决于用户的规格和需求。从搜索引擎优化 (SEO) 到潜在客户开发,网页抓取可以帮助企业做出数据驱动的决策。

网页抓取可以帮助您轻松提取大量数据,无需耗费任何时间和精力。使用网页抓取工具比手动为每个网站复制数据效率更高。

网页抓取方法

您可以使用多种网页抓取方法来抓取网站数据。以下是一些有助于高效抓取网站数据的方法:

设计你的抓取工具:

设计爬虫需要用某种编程语言编写代码,以便自动导航到网站并提取所需数据。您可以使用各种编程语言编写脚本,例如 Python、Javascript、C++ 等。Python 是目前最流行的网页爬虫语言,但 Javascript 中也有一些功能强大的库,例如 Unirest、Cheerio 和 Puppeteer,它们具有非常高性能的功能。

在设计抓取工具时,您必须首先通过检查 HTML 代码来搜索要抓取的某些元素标签,然后在开始解析 HTML 时将它们嵌入到代码中。

解析是从 HTML 文档中提取结构化数据的过程。Beautiful Soup (Python)、Cheerio (JavaScript) 和 group (Java) 是一些常用的 Web 解析库。

确定所需的标签后,您可以借助所选编程语言的网页抓取库向特定网站发送 HTTP 请求,然后使用网页解析库解析提取的数据。

同样需要注意的是,在设计爬虫时,你必须确保你的爬虫机器人不违反网站的使用条款。建议不要在小型网站上发出大量请求,因为不像大型企业那样,每个人都有高额的预算。

优点:完全控制您的刮板允许您根据您的刮板需求定制刮板。

缺点:如果刮擦操作不正确,制作刮擦器有时会成为一个耗时的过程。

阅读更多:如何使用 CSS 选择器小工具选择 HTML 元素

手动网页抓取:

手动网页抓取是指在浏览器中导航到特定网站,并将所需数据从网站复制到 Excel 或其他文件中的过程。此过程完全手动完成,此类网页抓取无需使用脚本或数据提取服务。

手动网页抓取的方法有很多种。你可以将整个网页下载为 HTML 文件,然后借助你使用的任何文本编辑器从 HTML 文件中筛选出所需数据,并存入电子表格或其他文件中。

手动抓取网站的另一种方法是使用浏览器检查工具,您可以在其中识别并选择包含要提取的数据的元素。

这种方法适用于小规模的网络数据提取,但大规模提取时可能会产生错误,而且比自动网络抓取需要更多的时间和精力。

优点:复制粘贴是一项基本技能。你不需要任何技术技能。

缺点:如果您要抓取大量网站,此方法需要付出大量努力并且非常耗时。

网页抓取服务:

许多公司和自由职业者为他们的客户提供网络抓取服务,您只需向他们提供 URL,他们就会以所需的格式向您发送数据。

如果您想抓取大量数据并且不想陷入复杂的抓取过程,这是最好的方法之一。

一般来说,为客户提供网页抓取服务的公司已经拥有现成的脚本,并且他们还有一个团队,专门处理抓取 URL 时可能出现的任何错误,例如 IP 禁令、验证码、超时错误等。他们可以更高效地处理大量数据,并且可以比您自己完成任务快得多。

优点:从长远来看,Web 抓取服务具有成本效益,因为它们可以使用现成的基础设施比您自己抓取数据的速度快得多。

缺点:无法控制抓取过程。

另一件重要的事情是,人们应该只信任信誉良好的服务来完成这些大任务,这些服务可以提供您想要的高质量数据。

Web抓取API:

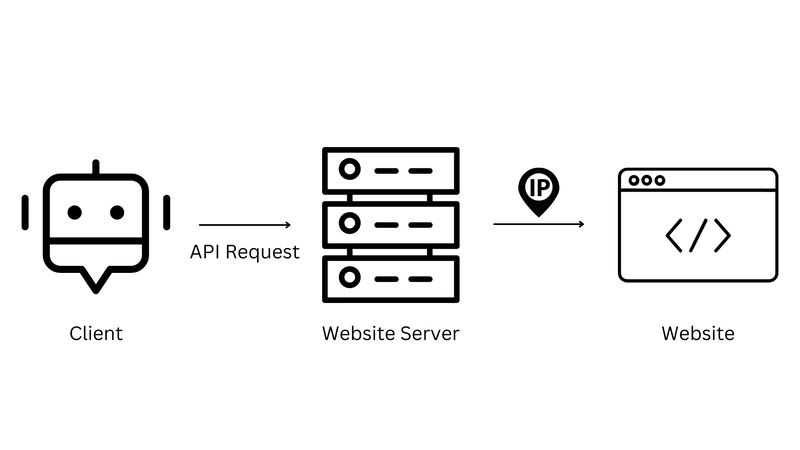

Web Scraping API是一款可以通过 API 调用从网站抓取数据的 API。您无需直接访问网页的 HTML 代码,API 会处理整个抓取过程。

API(应用程序编程接口)是一组允许一个软件系统与另一个软件系统通信的定义和协议。

Web Scraping API 易于使用,无需任何技术知识,只需在终端传递 URL,它就会以结构良好的格式返回结果。它们具有高度可扩展性,这意味着您可以抓取大量数据,而无需担心任何 IP 封禁或验证码。

优点:它们具有高度的可扩展性,并且您收到的数据准确、完整且高质量。

缺点:某些 Web Scraping API 会限制您单位时间内可以发送的请求数量,从而限制您可以收集的数据量。

因此,您可以根据自己的需求选择多种网页抓取方法。如果您想省钱,那么方法一和方法二最适合您。这两种方法还能让您完全掌控抓取过程。如果您不想被 IP 封禁、验证码和处理大量数据所困扰,那么后两种方法则是您的最佳选择。

网页抓取合法吗?

Web Scraping 的合法性仍是一个不断发展的过程,但判断取决于各种因素,例如如何抓取任何特定数据以及如何使用它。

一般来说,如果您想将数据用于研究目的、教育项目、价格比较等,那么网络抓取可以被视为合法。但如果网站在其条款中严格禁止未经其许可的任何形式的网络抓取,则合法性可能会受到影响。

如果网络抓取被用于获取任何不公平的竞争优势,或用于未经授权的用途(例如窃取网站敏感数据),则也可能被视为非法。您还可能在从网站提取数据的过程中被封禁,并因违反任何版权法而被起诉。

总的来说,如果使用得当,网页抓取是一种非常有效的工具,但必须牢记,如果恶意使用,可能会产生法律后果。此外,还必须遵守网站的服务条款,不得以任何方式损害其服务或功能。

最适合网页抓取的语言

您可以使用多种编程语言进行网页抓取,具体取决于您的需求。让我们来讨论一下:

Python: Python 是开发者中最流行的网页抓取语言,这得益于其简单易用以及丰富的库和框架,包括 Scrapy 和 Beautiful Soup。此外,就网页抓取而言,Python 的社区支持也相当不错。

Javascript: Javascript 也正逐渐成为网页抓取的首选语言之一,因为它能够从使用 JavaScript 动态加载网页的网站抓取数据。Unirest、Puppeteer 和 Cheerio 等库让 JavaScript 数据抓取变得更加容易。

Java: Java 是另一种在大型项目中广泛使用的流行语言。像 Jsoup 这样的库可以更轻松地从网站抓取数据。

Ruby:一种高级编程语言,具有 Nokogiri 和 Mechanize 等库,可以更轻松地从网站抓取数据。

还有更多这样的例子,如 C#、R、PHP 等,可用于网络抓取,但最终,这取决于项目的要求。

我如何学习网页抓取?

如今,网页抓取正成为一项重要的赚钱技能。几乎每个网站都需要潜在客户来拓展业务,而这唯有网页抓取才能实现。每个活跃的网站都希望追踪自身在谷歌上的排名,而这唯有谷歌抓取才能实现。因此,网页抓取已成为企业发展的主要支柱之一。

在本节中,我们将讨论开始网页抓取的各种方法:

自学:你也可以通过自己做些小项目来学习网页爬虫。首先,当你对一些小项目感到熟练后,可以先研究一下,然后尝试从那些比较难爬取的网站中提取数据。

在线教程:您还可以参加 Udemy、Coursera 等教育平台上提供的各种在线课程。这些老师经验丰富,将以结构化的方式带您从初学者到高级水平。

但这还需要你学习用于网页抓取的编程语言。先从基础到中级学习这门语言,当你积累了足够的经验后,再参加这些课程,开启你的网页抓取之旅。

加入在线社区:建议加入与你的编程语言或网页抓取相关的社区,这样你在制作抓取工具时遇到错误时可以随时提问。你可以加入 Reddit、Discord 等平台上的各种社区。他们的服务器上有一些经验丰富的人员,即使是高深的问题也能轻松解决。

阅读文章:互联网上有大量关于网页抓取的文章,可以帮助您从零基础入门成为网页抓取专家。您可以通过这些教程学习如何抓取 Google、Amazon 和 LinkedIn 等高级网站的数据,并附有完整的讲解。

因此,学习网页爬虫有很多入门方法,但最终的关键在于学习新知识时要坚持不懈、专心致志。你可以从每天至少学习 1 个小时开始,然后慢慢增加学习时间,直到投入 100% 的精力。这将帮助你掌握爬虫技术,最终成为一名精通的学习者。

结论

在本教程中,我们学习了网页抓取、一些网页抓取方法,以及最后如何开始您的网页抓取之旅。

我们还了解到,网络抓取是一项很有价值的技能,它能让你从不同的网站抓取数据,这些数据可以用于价格监控、媒体监控、搜索引擎优化等研究目的。我们还可以借助网络抓取为我们的业务产生大量的潜在客户,从而保持竞争优势。

希望本教程能让您全面了解网页抓取。如果我遗漏了任何内容,请随时给我留言。如果您认为我们可以完成您的自定义抓取项目,请随时联系我们。请在Twitter上关注我。感谢您的阅读!

其他资源

我准备了一份关于 Google 数据抓取的完整博客列表,可以让您对网页数据抓取有所了解:

作者

我叫 Darshan,是serpdog.io的创始人。我热爱创建爬虫。我目前为几家跨国公司工作,通过无缝数据管道为他们提供 Google 搜索数据。

鏂囩珷鏉ユ簮锛�https://dev.to/apiforseo/web-scraping-a-complete-guide-1lk2 后端开发教程 - Java、Spring Boot 实战 - msg200.com

后端开发教程 - Java、Spring Boot 实战 - msg200.com